Можно ли скопировать любой сайт в интернете? Да, конечно. Для этого потребуется всего пара минут и несколько кликов. Но с одной оговоркой - вы получите его html-код, внешний вид сайта, без сложных скриптов (для их реализации потребуется программист). Этот вариант подойдет для тех, кому нужно скопировать несложный сайт - например, лендинг конкурента и быстро запустить рекламу.

- Скопировать сайт целиком и переделать?

- 7 способов бесплатно скопировать сайт

- Итог

- FAQ

- Законно ли копировать сайты целиком для личного использования?

- Какой инструмент лучше для новичков: HTTrack или Web ScrapBook?

- Можно ли скопировать сайт без установки специальных программ?

- Как сохранить сайт в одном HTML-файле для быстрого доступа?

- Как сохранить динамический контент (например, JavaScript) при копировании сайта?

Скопировать сайт целиком и переделать?

Стоит понимать, что, копируя сайт, вы с большой вероятностью столкнетесь с “сюрпризами”, которые обязательно нужно проверить перед работой:

- корректная верстка (все элементы на своих местах, работает исправно и мобильная версия, и десктоп),

- все картинки загружаются (при копировании, возможно, что-то не сохранилось, неправильно указан путь файла в коде),

- активные элементы работают исправно (кнопки, формы).

Все эти мелочи исправляются за несколько минут самостоятельно, либо с помощью фрилансеров, если речь идет о скриптах.

Для самостоятельной работы с кодом рекомендуем: Sublime Text, Visual Studio Code, Atom.

Далее, все что вам останется - перенести сайт на ваш хостинг с доменом.

Так чем же скопировать сайт?

7 способов бесплатно скопировать сайт

Самый простой способ: “Ctrl+S” - команда в браузере, которая сохраняет текущую страницу. Быстро, без посторонних сервисов, но с высокой вероятностью потерять часть сайта (динамические элементы, скрипт, формы) - больше подойдет для копирования контента страниц.

Если вам нужно скопировать работоспособный одностраничный сайт, то лучше обратиться к специальным сервисам, которые помимо HTML, копируют CSS, JavaScript, все изображения, анимации, ссылки и формы. Тем более, что часть из них полностью бесплатна.

Web2zip

https://web2zip.ru/ - бесплатный онлайн сервис с простым интерфейсом. Вводим нужный нам url сайта, нажимаем скопировать и получаем сайт в архиве с возможностью предпросмотра онлайн.

Сервис копирует HTML, CSS, JavaScript, изображения и шрифты.

Saveweb2zip

https://saveweb2zip.com/ru - онлайн-сервис с бесплатной возможностью скачать сайт, сохраняя HTML, CSS, JavaScript, изображения и шрифты. За дополнительную плату можно заказать настройку форм и решение других вопросов.

При скачивании есть возможность автоматически переименовать названия файлов, скопировать мобильную версию сайта.

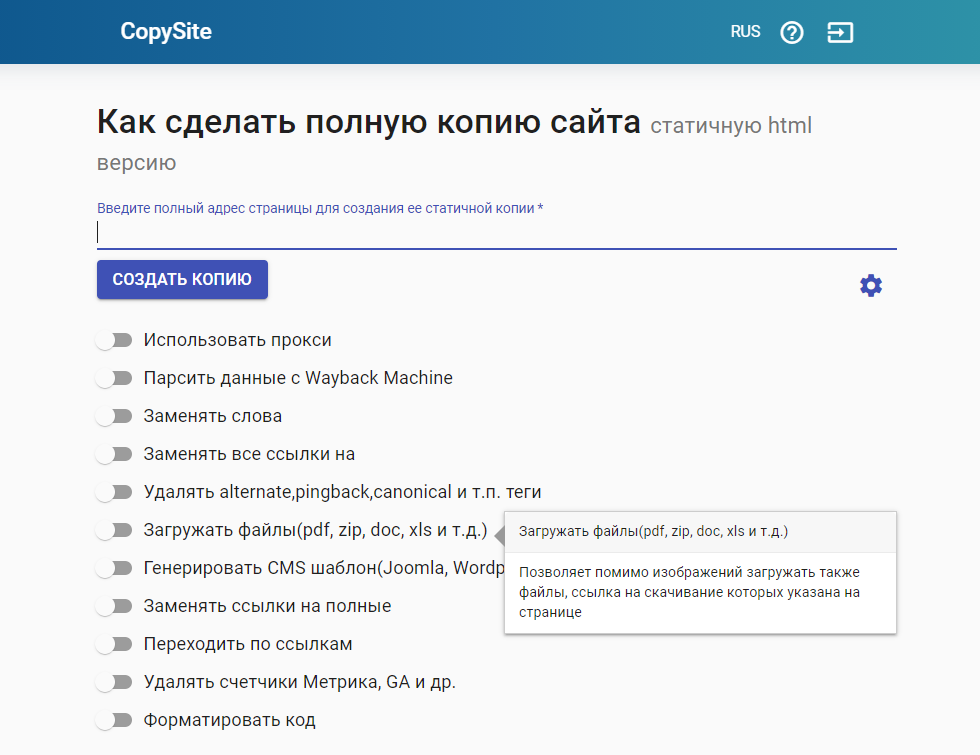

CopySite

https://copysite.link/ - онлайн-сервис уже с платной подпиской, но более широким функционалом. При скачивании есть возможность использовать прокси, заменять слова, ссылки, автоматически удалять теги, счетчики метрик и форматировать код.

Стоимость - 300 руб./мес., 200 руб./неделя, 75 руб./сутки.

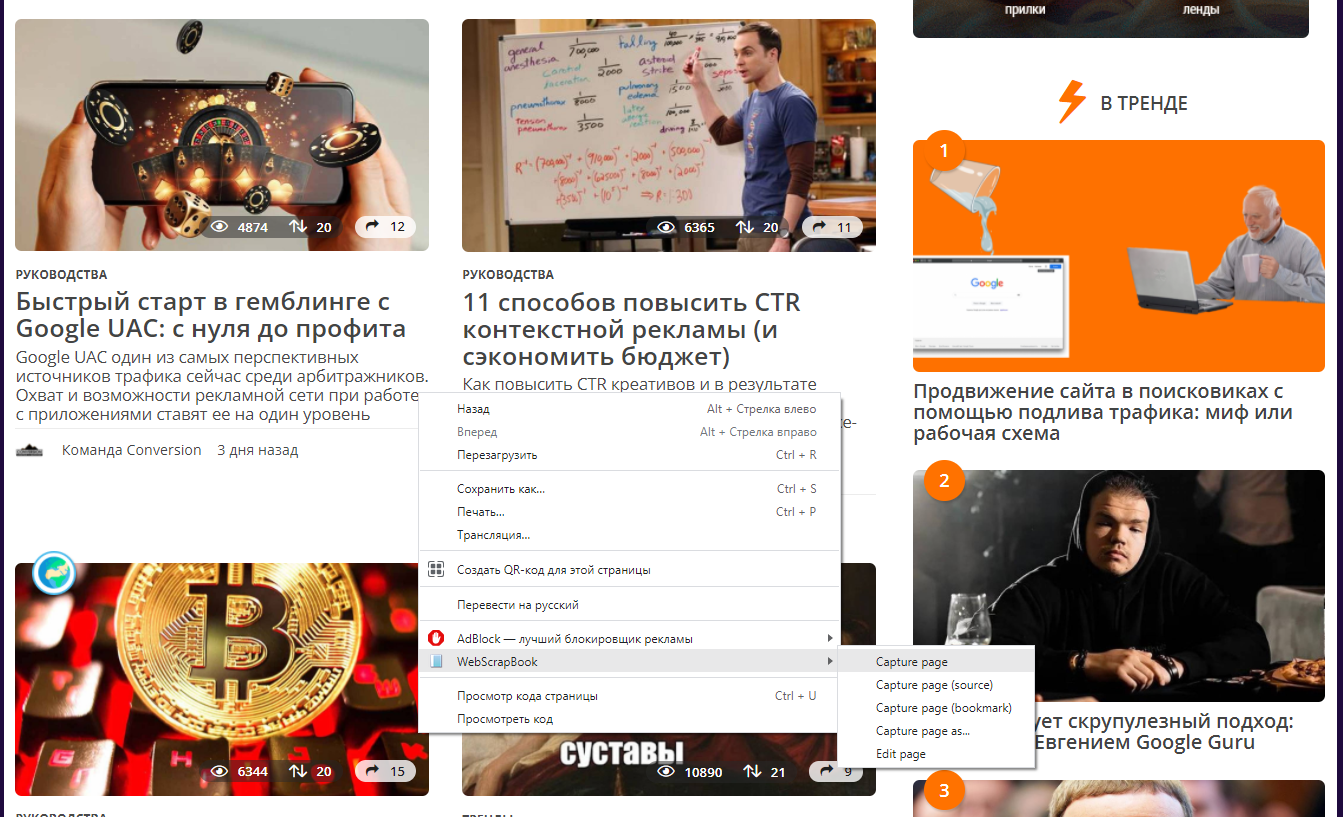

Web ScrapBook

Web ScrapBook - бесплатное браузерное расширение, которое позволяет скачивать необходимые страницы сайта не покидая целевую страницу.

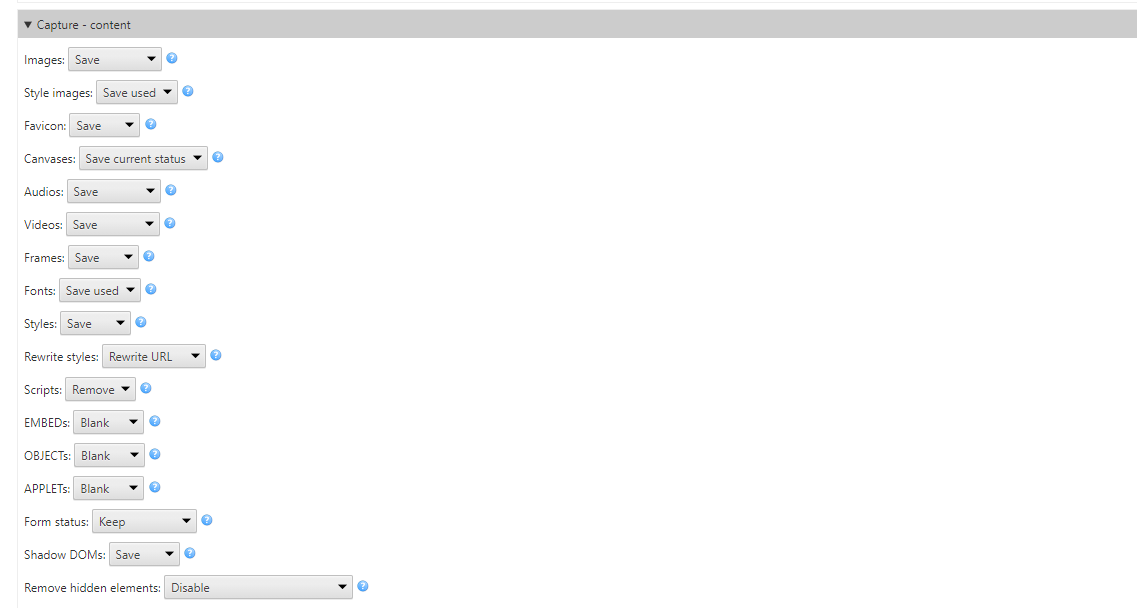

Сервис имеет широкий опционал для настройки, позволяющий работать с мультимедийными файлами и скриптами: скачивать, вырезать, заменять, пропускать.

Httrack

Httrack - бесплатный локальный сервис, для работы нужно устанавливать на компьютер. С задачей справляется отлично, основное преимущество - можно скачивать несколько сайтов одновременно (списком загружать url), всегда готов к работе (не зависит от работоспособности онлайн-сервисов), менее удобен, чем решения выше.

Cyotek WebCopy

Cyotek WebCopy - один из сервисов компании Cyotek, требует установки, но абсолютно бесплатный. Копирует контент, а также стили, но теряет JavaScript.

Отлично подойдет для парсинга контента сайтов и копировании простых сайтов.

wget

wget - консольная утилита, которая позволяет копировать сайты без графического интерфейса, используя команду типа “wget -r -k -l 7 -p -E -nc http:/vash.site/”

Параметры отвечают за:

- -r — указывает на то, что нужно переходить по ссылкам на сайте, чтобы скачивать все подкаталоги и все файлы в подкаталогах.

- -k — преобразует все ссылки в скаченных файлах, чтобы по ним можно было переходить на локальном компьютере в автономном режиме.

- -p — указывает на то, что нужно загрузить все файлы, которые требуются для отображения страниц (изображения, css и т.д.).

- -l — определяет максимальную глубину вложенности страниц, которые нужно скачать. Обычно сайты имеют страницы с большой степенью вложенности и чтобы wget не начал «закапываться», скачивая страницы, можно использовать этот параметр.

- -E — добавлять к загруженным файлам расширение .html.

- -nc — указывает на то, что существующие файлы не будут перезаписаны - например, при продолжении ранее прерванной загрузки сайта.

Среди платных решений стоит выделить также: RoboTools (2$ - 250 стр), Teleport Pro ($50).

Итог

Скопировать любой сайт в 2021 году может абсолютно каждый пользователь, который даже не знает про программирование, код и прочее - для этого есть широкий выбор сервисов. Они отлично решают вопрос скачивания одностраничных лендингов, сохраняя их работоспособность, но далеко не всегда могут справиться с сложными сайтами.

Если вам нужен качественный сайт или его копия, то рекомендуем все же обратиться к специалистам - тогда значительно повысится вероятность, что все элементы будут корректно работать, сайт - выполнять свою задачу, а трафик - приносить вам деньги.

Чтобы не было сюрпризов, обязательно проверяйте работоспособность сайта перед работой со всех устройств!

FAQ

Законно ли копировать сайты целиком для личного использования?

Копирование сайта без разрешения нарушает авторские права и условия использования большинства ресурсов, даже для личных целей. Исключения возможны для архивирования открытых данных (например, через Wayback Machine) или при наличии явного согласия владельца. Всегда проверяйте robots.txt и юридические аспекты.

Какой инструмент лучше для новичков: HTTrack или Web ScrapBook?

Web ScrapBook проще для новичков: работает как браузерное расширение, сохраняет страницы с интерактивными элементами и не требует настройки командной строки. HTTrack мощнее для полного копирования сайтов, но сложнее в освоении. Для базовых задач выбирайте Web ScrapBook.

Можно ли скопировать сайт без установки специальных программ?

Да, через онлайн-сервисы (Web2zip, SavePageNow) или браузерные расширения (SingleFile, Web Scraper). Однако такие методы ограничены по объёму данных, безопасности и функционалу. Для полного копирования сложных сайтов десктопные инструменты вроде HTTrack остаются надёжнее.

Как сохранить сайт в одном HTML-файле для быстрого доступа?

Используйте расширение SingleFile для Chrome/Firefox или функцию «Сохранить как» в браузере (тип «Веб-страница, полностью»). Это объединит ресурсы в один файл, но динамический контент (скрипты, формы) может работать некорректно. Для архивов лучше подойдут PDF или MHTML.

Как сохранить динамический контент (например, JavaScript) при копировании сайта?

Стандартные инструменты (HTTrack, wget) не сохраняют динамику. Для этого нужны решения с рендерингом через браузер: Selenium, Puppeteer или ArchiveBox. Они запускают страницу в реальном времени, сохраняя выполнение скриптов. Но полное копирование интерактивных приложений остается технически сложной задачей