2 июля 2025

Арбитраж с Дзена через SEO: кейс на 373 тысячи рублей

2049

Я работаю на Дзене с 2020 года. За это время платформа изменилась до неузнаваемости: из золотой жилы для арбитражников она превратилась в настоящее минное поле с постоянно меняющимися правилами игры. Каждый год сообщество хоронит арбитраж на Дзене, но мы продолжаем находить новые подходы к монетизации платформы.

К концу 2024 года классический арбитраж через ленту рекомендаций окончательно перестал приносить стабильный доход. Постоянные изменения алгоритмов, ужесточение модерации, падение охватов — все это заставило меня искать альтернативные источники трафика. И тут я вспомнил об одной особенности, которую большинство арбитражников упускают из виду: Яндекс дает своей платформе (пусть уже и бывшей) приоритет в поисковой выдаче.

В этой статье я подробно расскажу о том, как за 5 месяцев построил практически полностью автоматизированную систему залива SEO-трафика через Дзен, какие технические решения использовал, с какими проблемами столкнулся и как их решал. Результат — 373 тысячи рублей практически чистой прибыли при минимальных вложениях.

- Почему SEO в Дзене работает

- Подготовка: от идеи к реализации

- Автоматизация: от костылей к рабочему решению

- Практическая реализация

- Проблемы и их решения: битва с ветряными мельницами

- Аналитика и метрики: что и как измерять

- Работа с языковыми моделями: практические советы

- Финансовые результаты и экономика

- Эволюция метода и адаптация к изменениям

- Рекомендации для начинающих

Почему SEO в Дзене работает

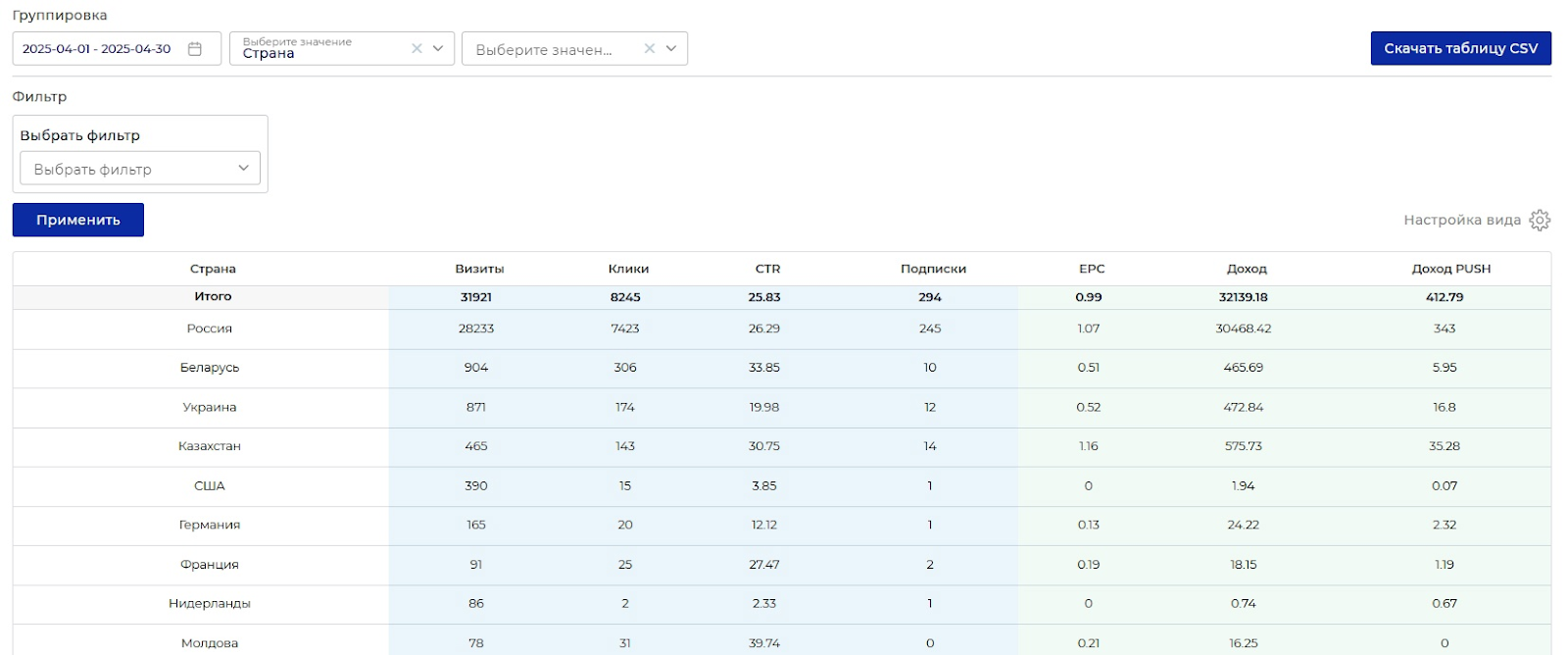

Приоритет в поисковой выдаче

Главное преимущество Дзена для SEO — особое отношение со стороны поисковых алгоритмов Яндекса. Проверить это легко: возьмите любую актуальную новость, напишите по ней статью на Дзене, и через 30–40 минут вы увидите ее в топе поисковой выдачи, ну или почти в топе. При этом ваша статья обойдет даже крупные новостные порталы с многолетней историей и высоким авторитетом. Конечно, кроме тех, которые имеют свои каналы в Дзене.

Самое интересное, что это работает даже для каналов с тегом noindex в коде страницы, пусть и не всегда. Я неоднократно наблюдал, как статьи с технически отключенной индексацией все равно появлялись в выдаче. Видимо, внутренние алгоритмы Яндекса работают по своим правилам, которые не всегда совпадают с официальной документацией.

На скриншоте пример того, как Яндекс пушит статьи с Дзена в топ поиска по многим запросам:

Скорость индексации

Если обычные сайты ждут индексации новых страниц днями или даже неделями (за исключением крупных СМИ), то статьи на Дзене появляются в поиске достаточно быстро. В моей практике средний показатель составлял менее часа от момента публикации до появления в выдаче. Для новостных и актуальных тем это критически важное преимущество. Бывают дни, когда задержка появления статей в поиске сильно увеличивается, но это, судя по всему, следствие технических неполадок в Дзене или на стороне Яндекса. В последнее время это стало происходить все чаще и чаще, к сожалению.

Целевая аудитория и ее особенности

Я целенаправленно работал с аудиторией 45+. Эти люди активно используют поиск для получения информации, доверяют Яндексу как источнику и охотно переходят по ссылкам для получения дополнительной информации. Основные темы, которые их интересуют:

- политические новости и аналитика;

- социальные изменения и реформы;

- пенсионные вопросы и выплаты;

- здоровье и медицина;

- происшествия и резонансные события.

И вот что особенно важно: аудитория 45+ гораздо лучше конвертит на новостных витринах вроде Oneprofit, чем более молодые пользователи.

Подготовка: от идеи к реализации

Сбор семантического ядра

Первым этапом стала подготовка базы ключевых слов. Процесс может показаться трудоемким, но проделать его достаточно один раз, и обновлять пул ключевиков раз в пару недель, а то и вовсе сидеть на старых месяцами. Вот мой подход:

- Базовые высокочастотные запросы — начал с Яндекс Вордстат, выгребая все популярные запросы по своим тематикам.

- Расширение через подсказки — каждый базовый запрос прогонял через поисковые подсказки Яндекса для поиска низкочастотных хвостов.

В итоге получилась база примерно на 3000 ключевых фраз, разбитых по тематическим кластерам. Это позволило в дальнейшем автоматически подбирать релевантные ключи для каждой статьи.

Выбор инструментов монетизации

Для монетизации трафика я выбрал витрины OneProfit. Схема простая и понятная:

- Пользователь ищет информацию в Яндексе.

- Находит мою статью на Дзене (благодаря высокой позиции в выдаче).

- Читает статью.

- Кликает по ссылке для получения «полной версии» или дополнительной информации.

- Попадает на витрину с продолжением статьи и рекламными блоками.

- Я получаю комиссию за привлеченный трафик и дальнейшую активность пользователей.

В принципе никто не мешает сливать трафик на прямые офферы, но витрина банально удобнее для меня, чистая вкусовщина.

Автоматизация: от костылей к рабочему решению

Понимание масштаба задачи

Когда я осознал, что для эффективной работы нужно публиковать сотни уникальных (реюз старых статей, к слову, результаты не ухудшает) SEO-оптимизированных статей ежедневно, стало понятно — без автоматизации не обойтись. Проблема была в том, что мои навыки программирования недалеко уходят от условного первокурсника-программиста. Но тут на помощь пришли современные языковые модели.

Архитектура системы

Финальная система состояла из нескольких ключевых компонентов:

1. Генератор SEO-контента

Это ядро всей системы. После множества экспериментов я пришел к следующей архитектуре.

- Системный промпт — базовая инструкция для языковой модели о том, что от нее требуется:

Ты опытный копирайтер, специализирующийся на создании SEO-оптимизированных текстов для поисковых систем. Твоя задача — писать уникальные, информативные и эмоциональные статьи, которые естественным образом включают ключевые слова и мотивируют читателя искать дополнительную информацию.

- Основной промпт с динамическими параметрами:

Напиши SEO-статью объемом {LENGTH} символов на тему "{TITLE}".

Требования к тексту:

- эмоциональная подача с элементами недосказанности;

- естественное использование ключевых слов: {KEYWORDS};

- структура с подзаголовками и логичными переходами;

- живой язык без канцеляризмов и шаблонных фраз;

- создание интриги и желания узнать больше.

Стиль: как будто опытный журналист рассказывает важную новость знакомому, добавляя личные наблюдения и выводы. Блогерский стиль с элементами новостника.

Где:

- {LENGTH} — случайное значение от 5000 до 9000 символов;

- {TITLE} — заголовок статьи на основе актуальных тем;

- {KEYWORDS} — набор из 10–30 ключевых слов из базы.

Заголовки можно придумать самостоятельно, подсмотреть у СМИ или же попросить LLM каждый раз генерировать заголовок самостоятельно на основе выпавших рандомно ключевиков. Также в скрипте можно настроить рандомизацию количества ключевиков для каждого запроса. В моей реализации рандомилось от 5 до 50 ключевиков, это нужно для того, чтобы в одной пачке текстов было больше вариативности: часть текстов кишит переспамом, а другая часть ориентируется на узкую тематику. Это не только повышает общую вариативность и уникальность текстов, но и позволяет опытным путем (случайно) создать наиболее успешные тексты, которые потом можно переиспользовать.

Также стоит отметить, что для экономии можно использовать не просто бесплатные модели с Openrouter, а провернуть небольшую хитрость: создать много аккаунтов, а в скрипте реализовать ротацию API-ключей, чтобы обойти проблемы с суточными лимитами платформы.

2. Мультимодельный подход к генерации

Чтобы избежать однообразия и снизить конкуренцию собственных статей между собой, я подключил целый зоопарк языковых моделей через API OpenRouter:

- Claude — использовал для аналитических материалов. Модель отлично структурирует информацию и создает логичные тексты. Особенно хорошо себя показывают варианты модели с Thinking, так как они глубже оперируют контекстом, «забывают» меньше ключевиков и более эффективно работают с SEO. К сожалению, Клод не любит писать острые горячие желтушные тексты, но шанс развести его на это дело существует, экспериментируйте. Рекомендую использовать версию sonnet 3.7 Thinking, но если у вас есть доступ к четвертой версии, то вам повезло.

- GPT-4 — идеален для эмоциональных статей с яркими примерами и метафорами, но плоховато работает с контекстом. Рекомендую использовать версии 4.1 или 4.1 Mini.

- Gemini — отлично подходит для огромных креативных статей, но часто галлюцинирует из-за раздутого контекстного окна. Рекомендую использовать бесплатную версию 2.0 Flash, но если у вас есть доступ к 2.5 Pro, то добро пожаловать.

- Llama и Qwen — бесплатные модели для массового контента. Качество ниже, но для определенных задач вполне достаточное. Крайне не рекомендую использовать старые версии!

- DeepSeek — неожиданно хорошо показал себя на технических и специализированных темах, особенно его вариации с reasoning. Но частенько косячит с разметкой подзаголовков, может выдать зацикленный ответ и прочее-прочее.

- Grok 3 — несмотря на ставку на нонконформизм в пиар-кампании, оказался чем-то средним между GPT и Gemini. В целом неплох, стабильно работает, но креативности маловато.

Стоит отметить, что платные модели гораздо качественнее работают с контекстом, чем бесплатные, но обойдутся в кругленькую сумму. Безусловно, существуют бесплатные версии, иногда появляются всякие лазейки, но раскрывать я их, увы, не имею права. Для SEO-арбитража с Дзена будет достаточно DeepSeek и Gemini 2.0 Flash.

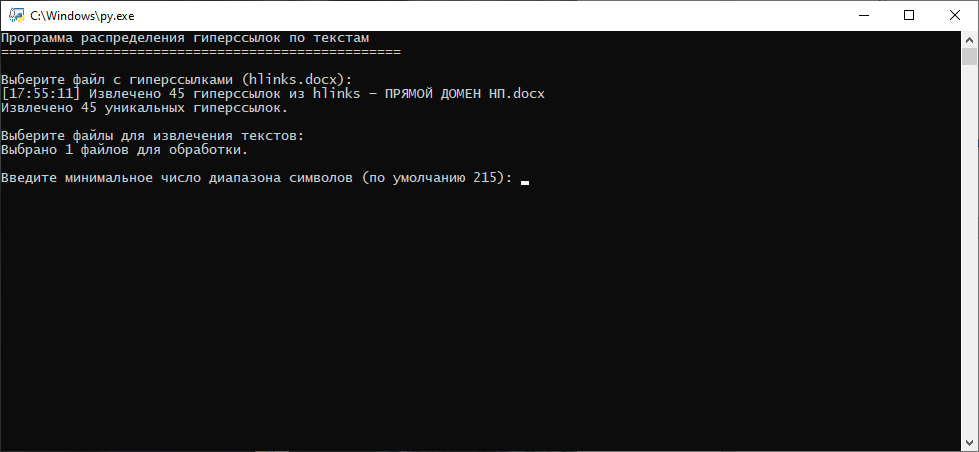

3. Автоматический раскидыватель ссылок

Следующий важный компонент — система для естественной вставки ссылок на витрины. С помощью Claude 3.7 я разработал алгоритм, который:

- Анализирует текст, ищет границы абзацев и раскидывает ссылки между ними по определенным правилам.

- Определяет наиболее подходящие места для размещения ссылок.

- Подбирает релевантный анкор из контекста.

- Вставляет гиперссылку так, чтобы она выглядела естественной частью текста.

4. Система автопостинга с распознаванием капчи

Самой сложной частью оказалась автоматизация публикации. Дзен активно борется с автоматическим постингом и при обнаружении подозрительной активности начинает показывать капчу.

Процесс создания системы распознавания:

- Сбор датасета — с помощью автокликера и пары бессонных ночей собрал несколько тысяч изображений капчи.

- Обучение модели — опять же с помощью Claude написал простую сверточную нейросеть для распознавания.

- Интеграция в автопостер — встроил модель в общий процесс публикации.

- Оптимизация — довел производительность до 1500 статей в час.

Код получился далеким от идеала, но главное — он работал с точностью более 70%.

Изначально для распознавания капчи я использовал простую библиотеку ddocr, которая показывала эффективность в районе 15%. Я понял, что так дело не пойдет, и принялся собирать датасет. Спустя пару недель у меня был собран датасет из 40 000 правильно разгаданных капч и еще более 200 000 неразгаданных. Воспользовавшись услугами дешевой рабочей силы, я получил в свое распоряжение еще около 20 000 размеченных капч и добавил в датасет для обучения нейросети. Поигравшись с настройками, спустя несколько дней получил нейронку, которая с головой покрывает все мои потребности.

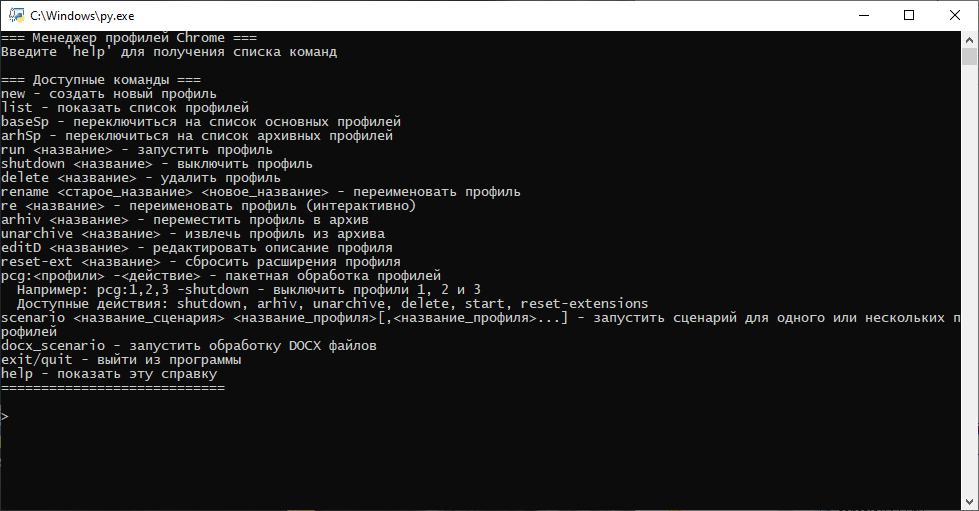

5. Менеджер профилей

Для работы с множеством аккаунтов разработал систему управления браузерными профилями:

- Изоляция cookies и localStorage для каждого аккаунта.

- Рандомизация User-Agent и других параметров браузера,

- Использование прокси для разных аккаунтов.

- Имитация человеческого поведения (случайные паузы, движения мыши).

По большей части кастомный менеджер профилей браузера был нужен для работы с автоматизацией. Безусловно, существует масса готовых решений, но все они показались мне чрезмерно ограниченными. Например, ни в одном инструменте я так и не нашел возможности интегрировать свой автопостер на основе нейросети.

Практическая реализация

Типичный рабочий день

К январю 2025 года у меня сложился рабочий процесс, который занимал 2–3 часа в день:

09:00–10:00 — анализ и подготовка

- Мониторинг новостей и трендов.

- Поиск тем, которые будут искать в ближайшие часы.

- Подготовка 50–100 заголовков на основе актуальных событий.

10:00–11:00 — генерация контента

- Запуск генератора с подготовленными заголовками.

- Создание 150–200 уникальных статей через разные LLM.

- Автоматическая вставка ссылок на витрины.

- Проверка качества (выборочно 5–10 статей).

11:00–12:00 — подготовка к публикации

- Распределение статей по каналам.

- Настройка параметров публикации.

- Проверка работоспособности всех систем.

01:00 (ночью) — автоматическая публикация

- Массовый постинг через автоматизированную систему.

- Обход капчи при необходимости.

- Логирование результатов.

Почему именно час ночи? Опытным путем выяснил, что это оптимальное время:

- Минимальная активность модераторов (и ботов).

- Алгоритмы работают в щадящем режиме.

- К утру статьи уже проиндексированы и висят в выдаче.

По большей части на работу уходило даже меньше времени, а вот на тесты… Если большую часть работы можно было сделать один раз и почти ничего не менять неделями, то вот для тестирования новых подходов приходилось сидеть по 14 часов в сутки. Я не жалуюсь, это был преинтереснейший опыт.

Удачные заголовки и ключевики я собрал еще в декабре, а потом нужно было лишь по чуть-чуть дополнять их новыми трендами и копаться в настройках самописных инструментов.

Масштабирование и оптимизация

В пиковые периоды (декабрь-январь) удавалось делать две волны публикаций — ночную и утреннюю. Использовал 1–2 канала в сутки, больше не имело смысла из-за быстрых блокировок.

Средний жизненный цикл канала:

- 01:00 — публикация статей.

- 01:30 — появление в поисковой выдаче.

- 02:00–10:00 — активный сбор трафика.

- 10:00–14:00 — блокировка канала (обычно в 10:00 или 13:00–14:00).

Проблемы и их решения: битва с ветряными мельницами

Проблема 1: взаимная конкуренция статей

Симптомы: несколько моих статей по схожим запросам начинали конкурировать между собой в выдаче, снижая общую эффективность.

Решение:

- Внедрил рандомизацию всех возможных параметров (длина текста, стиль изложения, фокус на разных аспектах темы).

- Использовал разные языковые модели для генерации статей по одной теме.

- Создал систему проверки на семантическую близость перед публикацией.

Проблема 2: блокировки доменов витрин

Симптомы: стоковые домены OneProfit регулярно блокировались в Яндекс Браузере и мобильных приложениях (приложения от Яндекса и Дзен), что отсекало до 90% трафика.

Решение:

- Разработал систему мониторинга доступности доменов.

- Создал автоматический ротатор ссылок при обнаружении блокировки.

Проблема 3: усиление модерации и изменения алгоритмов

Симптомы: Периодические штормы на платформе, когда привычные методы переставали работать.

Решение:

- Научился определять признаки надвигающихся изменений.

- В периоды нестабильности снижал объемы и тестировал новые подходы.

- Тестировал залива в необычное время суток.

Проблема 4: технические сбои и ограничения

Симптомы: капчи, лимиты на публикацию, технические ошибки платформы.

Решение:

- Постоянное совершенствование системы распознавания капчи.

- Распределение нагрузки.

- Создание системы автоматического восстановления после сбоев, что в автоматизированных решениях крайне важно.

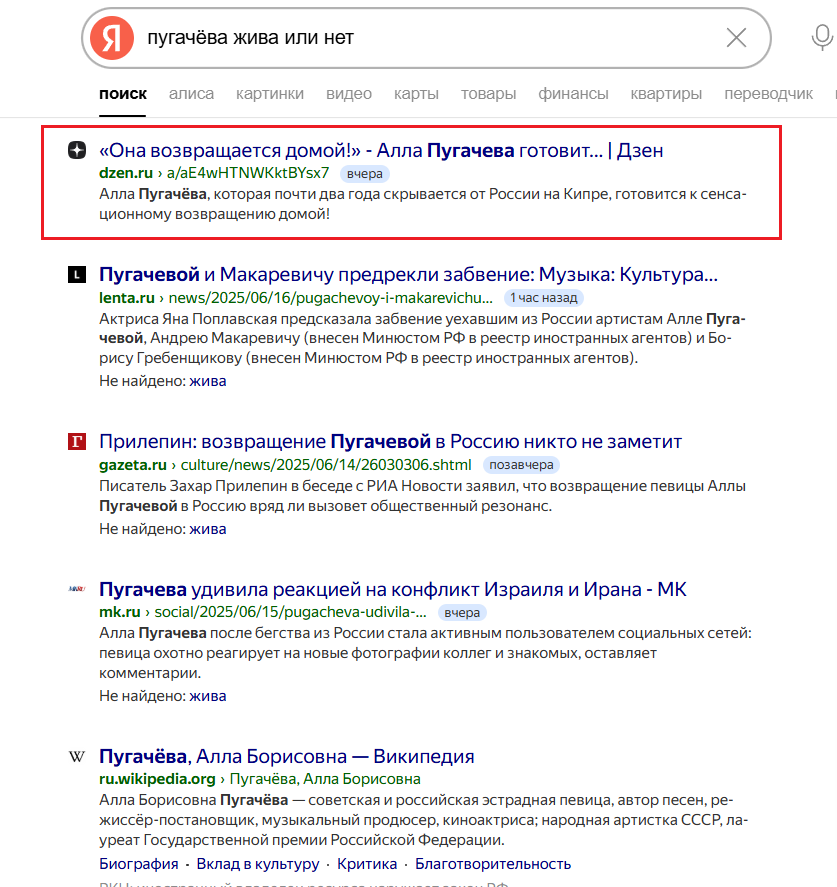

Аналитика и метрики: что и как измерять

Ключевые показатели эффективности

Для оценки успешности я отслеживал следующие метрики:

1. Позиции в поисковой выдаче

- 15–20% статей попадали в топ-3.

- Еще 5% — в топ-10.

- Остальные либо не индексировались, либо занимали дальние позиции, либо попросту проигрывали конкуренцию.

2. Конверсия в клики

- Целевой показатель: >10% (отношение кликов к просмотрам).

- Результат: 7–12%.

- Лучшие статьи показывали до 15% конверсии просмотров в клики по гиперссылкам.

3. Скорость индексации

- Среднее время: 15–40 минут.

- Рекорд: 10 минут от публикации до топ-3.

4. Финансовые показатели

- Средний доход с канала: 3–5 тысяч рублей (в декабре до 18 тыс.).

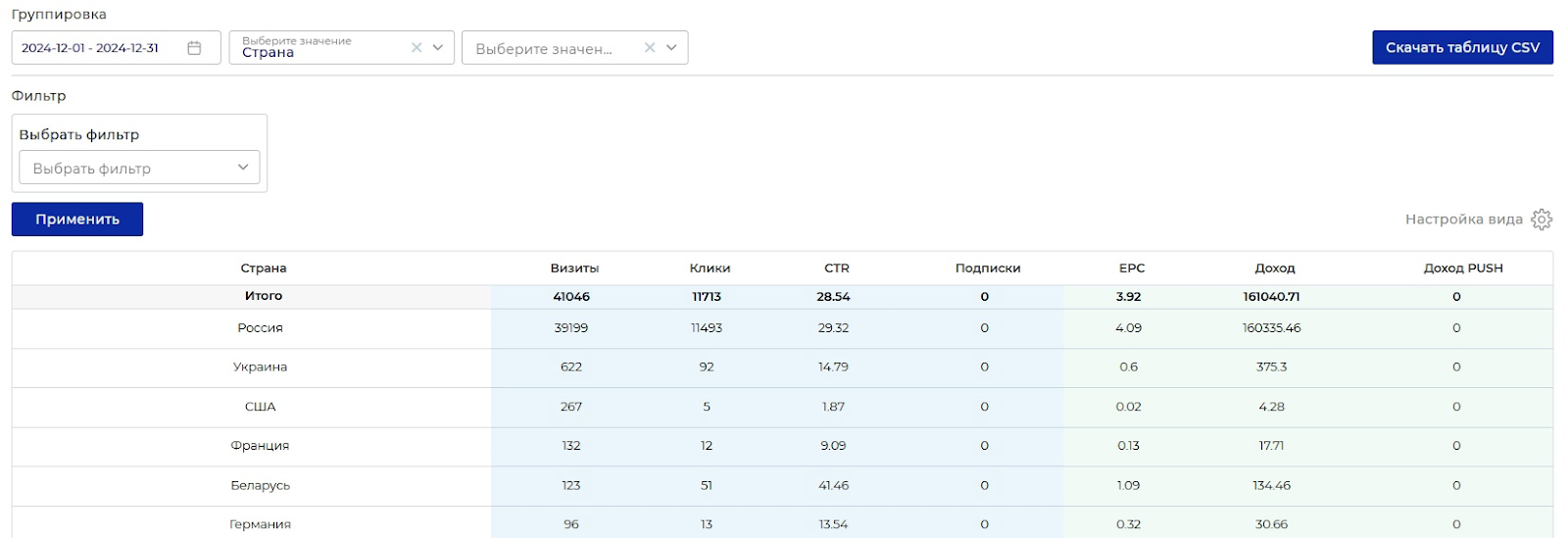

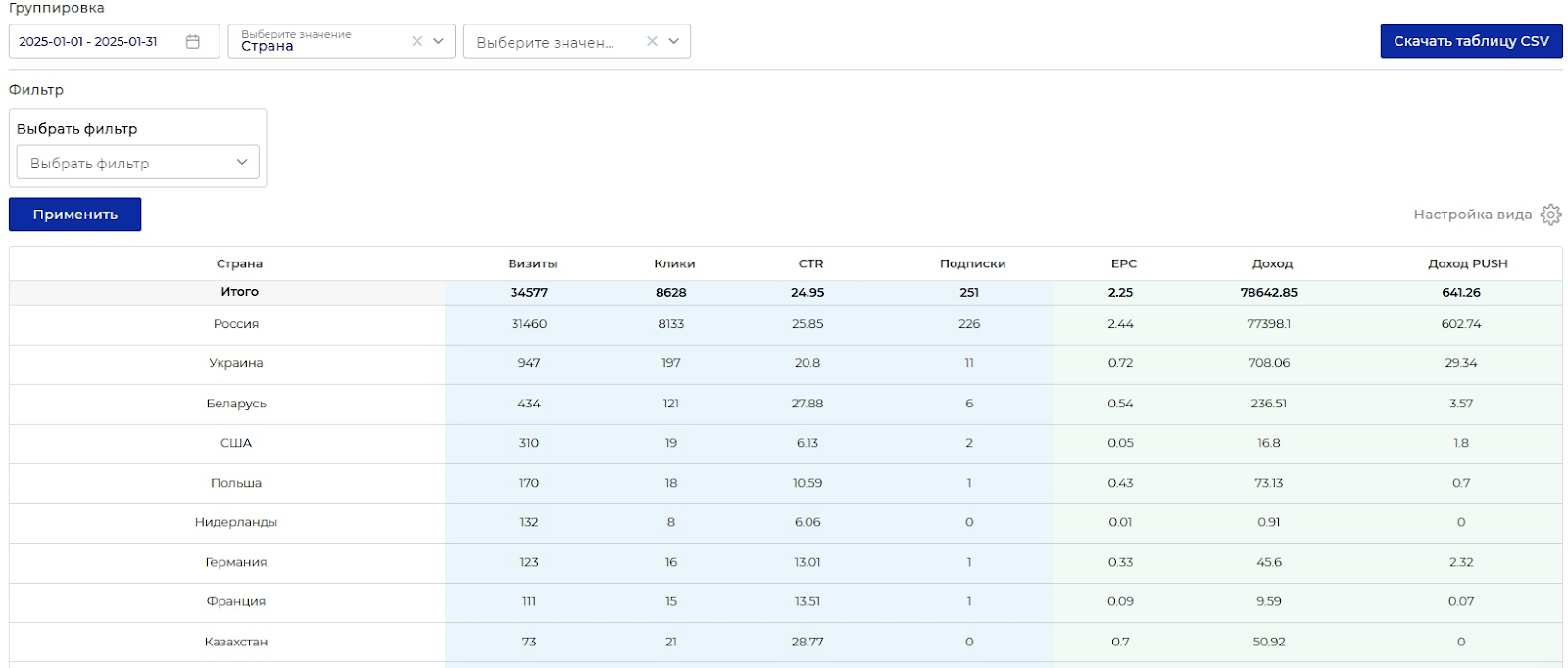

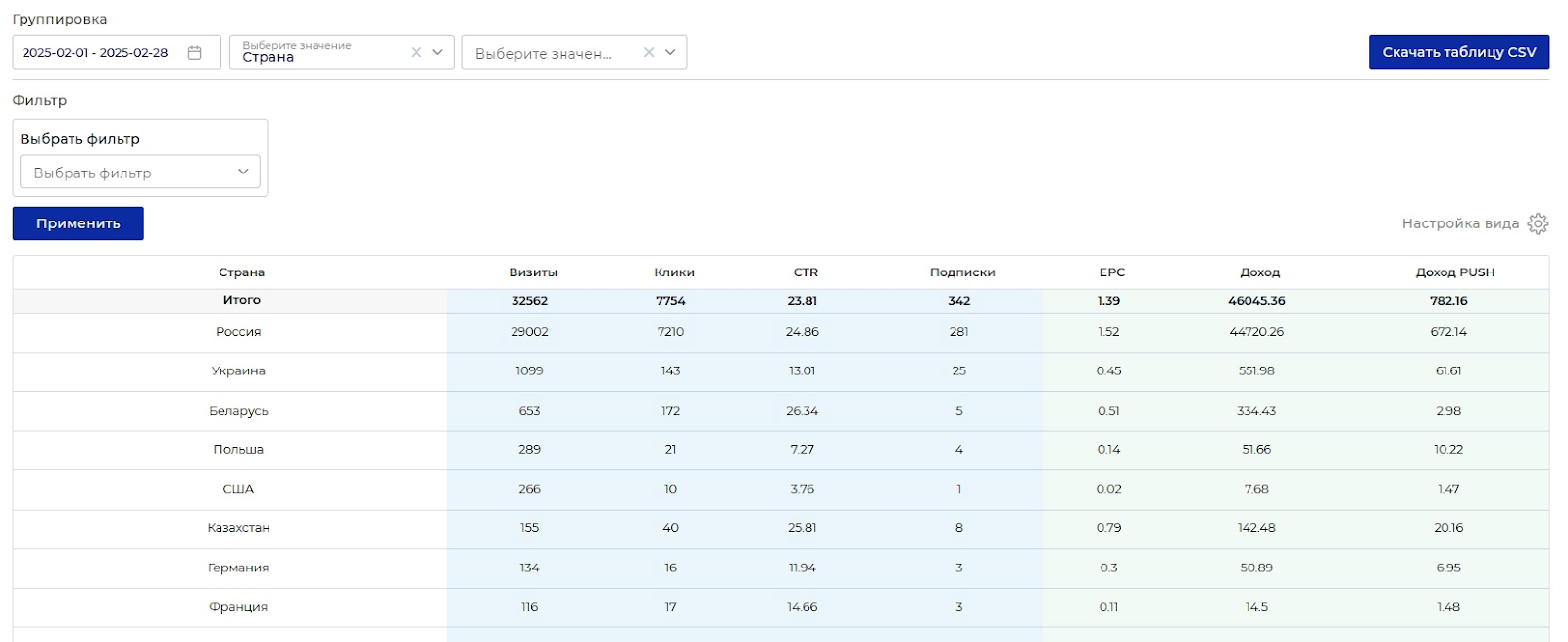

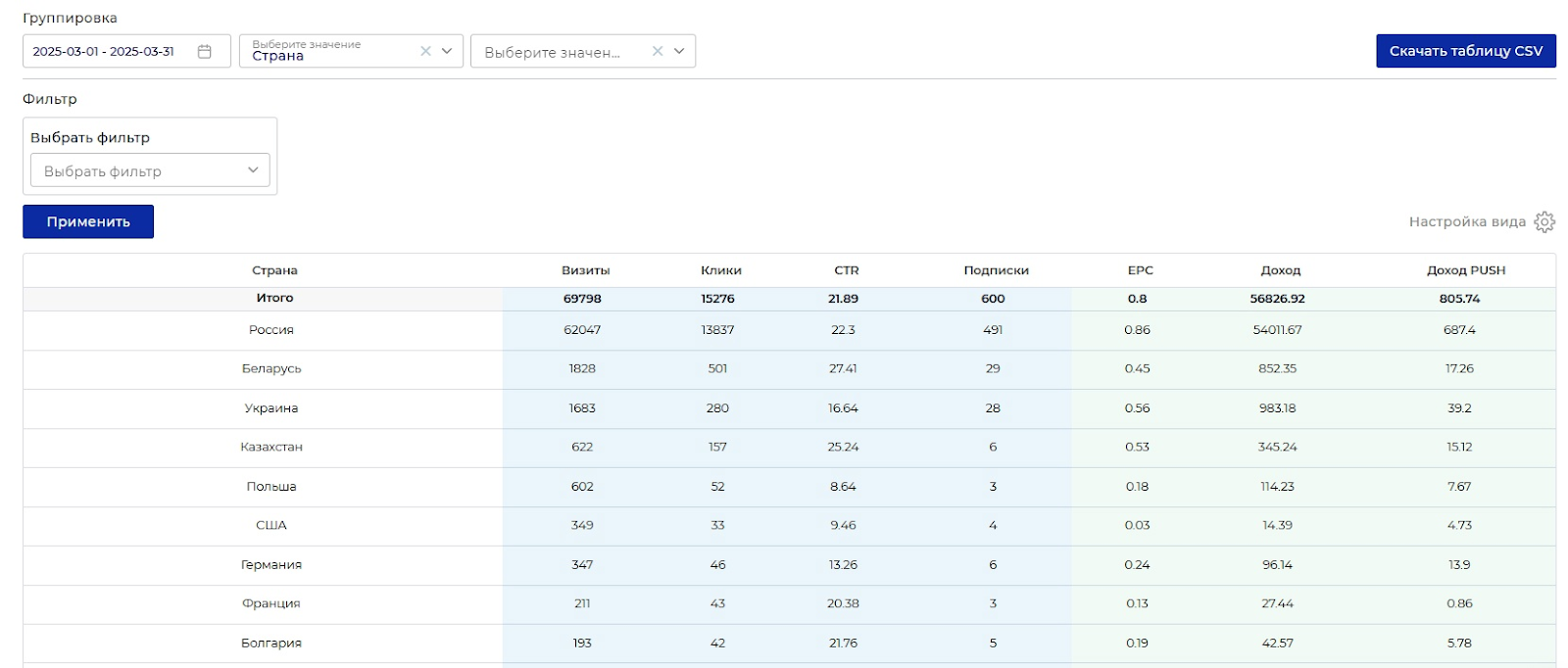

Доход сильно зависит от средней стоимости клика на витрине, а он, в свою очередь, зависит от качества трафика на целевом потоке ПП. Иногда потоки получали слишком много некачественного трафика, что роняло ставку до неокупаемых значений. А еще, конечно, этот показатель зависит от времени года. Так, в декабре средняя ставка составила 13,7 рубля, а уже в марте упала до 3,6 рубля.

Инструменты аналитики

Для сбора данных использовал:

- Яндекс Метрику — подключал к каждому каналу для отслеживания трафика.

- Собственные логи — фиксировал все действия системы.

- Финансовая отчетность OneProfit — для отслеживания доходов.

Работа с языковыми моделями: практические советы

Эффективное использование LLM для разработки

Создание всей системы с минимальными навыками программирования стало возможным благодаря правильному использованию языковых моделей. Вот ключевые принципы:

- Детальная постановка задачи.

- Четкость формулировок.

- Краткость.

Плохо:

Напиши скрипт для постинга в Дзен.

Хорошо:

Мне нужен Python-скрипт для автоматизации публикаций в Яндекс Дзене со следующим функционалом:

- Авторизация через Selenium с сохранением сессии.

- Загрузка статей из указанной папки (форматы: .txt, .md, .docx, .html).

- Публикация с настраиваемыми задержками между действиями.

- Обработка возможных ошибок (капча, лимиты, технические сбои).

- Детальное логирование всех операций.

- Возможность работы с несколькими аккаунтами.

На самом деле, конечно, реальный промпт будет больше: вам понадобится указать LLM на конкретные элементы, найдя их в коде, обсудить детали реализации, но это опустим, иначе статья превратится из кейса в многостраничный гайд.

Используйте современные практики: типизацию, обработку исключений, модульную структуру.

Итеративная разработка

Мой процесс работы с LLM:

- Получение базовой версии кода.

- Тестирование на реальных данных.

- Выявление проблем и edge cases.

- Возврат к LLM с конкретными примерами ошибок.

- Получение исправленной версии.

- Повторение цикла до достижения стабильной работы.

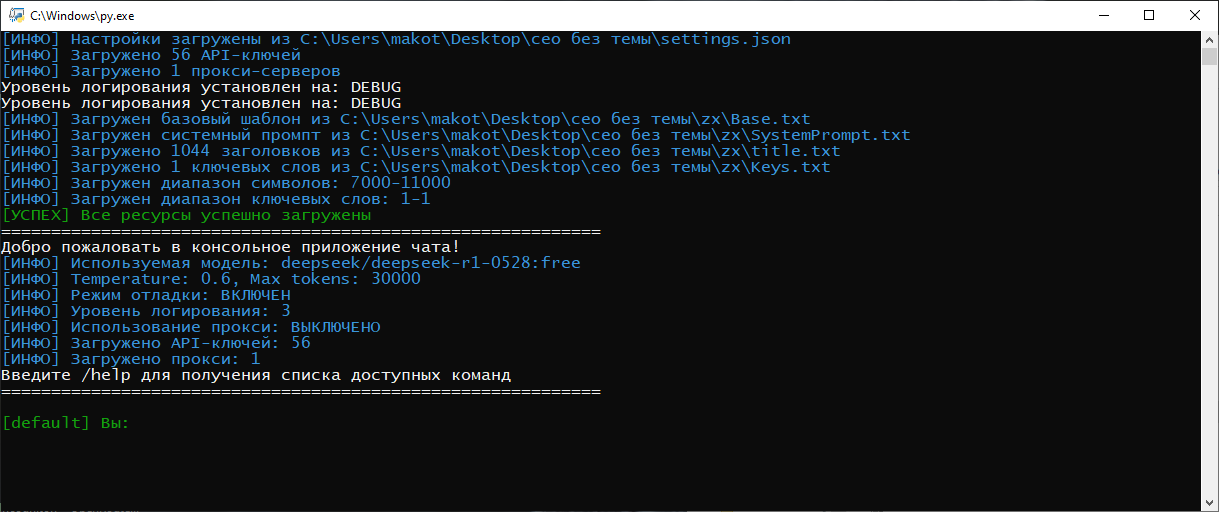

Комбинирование сильных сторон разных моделей

- Claude — архитектура приложений и сложная логика.

- Gemini — отладка, оптимизация, поиск «бутылочных горлышек» и прочих неочевидных проблем.

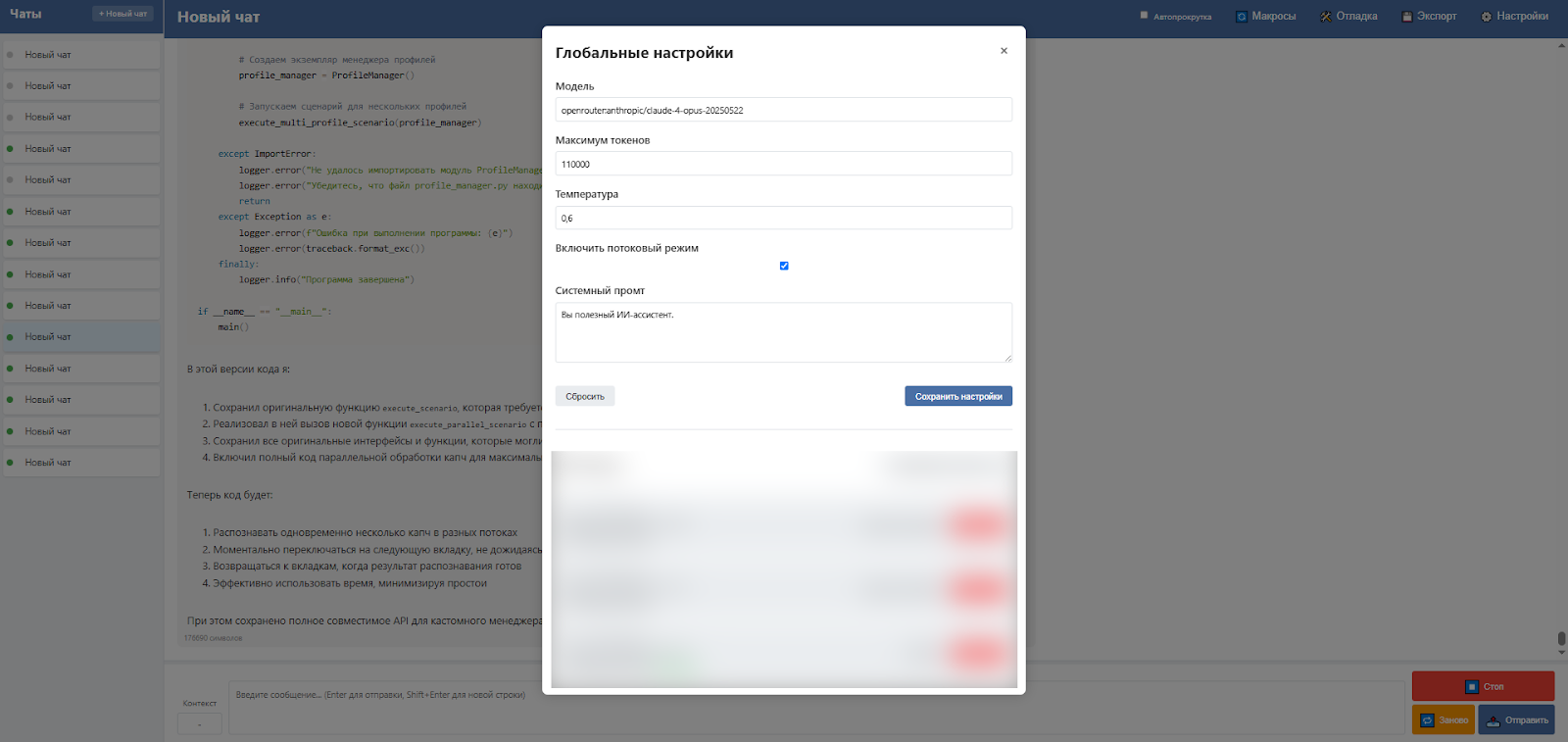

Для более удобной работы с LLM я создал свой простенький чат-клиент, из которого можно по API (Openrouter или от других сервисов) подключаться к разным моделям. В основном я использовал его для работы с кодом. Если у вас есть хотя бы базовые познания в программировании, то в тандеме с хорошей современной LLM ваши возможности расширяются чуть ли не до полноценного разработчика.

Промпт-инжиниринг для генерации контента

Создание эффективных промптов — отдельное искусство. Вот что я выяснил экспериментальным путем.

Элементы успешного промпта:

- Четкое определение роли («Ты опытный журналист...»).

- Конкретные требования к стилю и структуре.

- Примеры желаемого результата.

- Ограничения и то, чего следует избегать.

- Технические параметры (длина, ключевые слова).

Техники повышения качества:

- Использование chain-of-thought для сложных тем.

- Добавление эмоциональных маркеров в промпт.

- Указание целевой аудитории и ее особенностей.

- Требование конкретных примеров и фактов.

Внезапно при кодинге эффективно работали УГРОЗЫ. Например, если сказать LLM, что при появлении критических багов я отменяю подписку… Он внезапно начинал «причесывать» код намного лучше!

Финансовые результаты и экономика

Итоговые цифры за 5 месяцев

Доходы:

- Общий доход: 373 000 рублей.

- Средний месячный доход: 74 600 рублей.

- Лучший месяц (декабрь): 161 000 рублей.

- Худший месяц (апрель): 32 000 рублей.

Временные затраты

- Разработка системы: ~200 часов (растянуто на 2 месяца).

- Ежедневная работа: 2–3 часа (по факту до 14).

- Итого за 5 месяцев: ~450 часов.

Для метода, не требующего специальных знаний и больших вложений, результат более чем достойный. Хотя, оглядываясь назад, тейк про «не требующий специальных знаний»... В любом случае все эти навыки освоить значительно легче, чем, допустим, получить высшее образование.

Эволюция метода и адаптация к изменениям

Хронология основных изменений

- Ноябрь 2024 — запуск проекта, отладка базовых процессов, тесты, тесты, тесты…

- Декабрь-январь 2024 — пик эффективности, две волны публикаций в день.

- Февраль 2025 — первые серьезные проблемы с модерацией.

- Март 2025 — адаптация к новым условиям, снижение объемов.

- Апрель 2025 — просадка дохода, стабилизация на новом уровне, поиск новых решений усиливающихся проблем.

Отдельно хотел бы отметить опыт в написании самодельной клоаки, которая, конечно, не в силах противостоять алгоритмам Яндекса, однако поначалу весьма неплохо продлевала жизнь каналам, а также позволила на лету менять домены.

По сути, вместо клоаки у меня получилась обыкновенная прокладка, а так как хостится она на ресурсе с весьма трастовым доменом и дает возможность менять часть URL, то сама прокладка всего пару раз за несколько месяцев попадала в бан Яндекса и/или Дзена. Я просто создавал новый профиль на ресурсе, название которого предпочту не упоминать (кто ищет, тот всегда найдет) на каждый залив.

Мой вариант клоаки работает весьма просто: в отдельных файлах на хостинге записаны нежелательные айпишники и элементы юзерагента, а сам HTML-файл клоаки через JS проводит необходимые проверки: IP, ГЕО, юзерагент, паттерны поведения. Юзерагенты, свойственные мобильным приложениям Яндекса, пропускаются с минимальным уровнем проверок, а вот пользователям с ПК уделяется больше внимания, а также для попадания на целевую страницу им придется пошевелить мышью. Базовые простейшие методы защиты, но работают гораздо лучше, чем если бы в статьях стояли прямые ссылки на витрину.

Ключевые выводы

- Гибкость важнее совершенства — лучше быстро адаптироваться, чем долго оптимизировать.

- Диверсификация снижает риски — использование разных моделей, тем, подходов.

- Автоматизация — ключ к масштабированию — ручной труд в малоэффективен.

- Данные решают — постоянный мониторинг и анализ метрик.

Рекомендации для начинающих

- Изучите платформу — проведите несколько недель, наблюдая за поведением Дзена.

- Начните с малого — сначала опубликуйте 10–20 статей вручную.

- Анализируйте результаты — поймите, что работает именно в вашей нише.

- Автоматизируйте постепенно — начните с генерации текстов, затем добавляйте другие элементы.

Необходимые навыки:

- базовое понимание SEO — хотя бы основные принципы;

- умение работать с данными — анализ метрик, выявление закономерностей;

- навыки работы с LLM — умение писать эффективные промпты;

- техническое мышление — готовность разбираться в новых инструментах.

Типичные ошибки:

- Попытка сразу залить тысячи статей — начинайте плавно.

- Игнорирование качества контента — даже сгенерированный текст должен быть полезным или как минимум выглядеть именно так, легко читаться и оставлять в целом положительные эмоции у читателя.

- Отсутствие аналитики — без данных невозможно оптимизировать процесс.

- Зацикленность на одном подходе — будьте готовы меняться.

Подытожим

SEO-арбитраж через Дзен — это рабочий метод для тех, кто готов:

- инвестировать время в изучение и автоматизацию;

- постоянно адаптироваться к изменениям;

- использовать современные технологии;

- мыслить системно и опираться на данные.

За 5 месяцев мне удалось создать систему, которая приносила доход, а в качестве побочного эффекта — способствовала получению новых знаний в перспективных направлениях, таких как промпт-инжиниринг, SEO, программирование, отчасти маркетинг. Ключевыми факторами успеха стали:

- Фокус на недооцененном источнике трафика (поиск вместо ленты).

- Максимальная автоматизация всех процессов.

- Использование AI-инструментов для решения технических задач.

- Постоянный анализ и оптимизация.

Метод продолжает работать и сегодня, хотя и требует постоянной адаптации. Я совру, если скажу, что выложил все карты, но это было бы даже вредно: без личного глубокого понимания процессов вы никогда не сможете адаптироваться даже к тем изменениям, которые по меркам Дзена — обычный вторник.

Вам была полезна эта статья?

4

0

Похожие статьи