25 января 2019

Преступления и наказания: всё о санкциях Google

4232

Если сайт не соответствует требованиям Google, он неминуемо оказывается на дне выдачи. Читайте о том, за что поисковая система может «наказать» сайт, какие виды санкций Google бывают и как от них избавиться.

Виды санкций Google

Для начала коротко о том, какие бывают санкции Google.

1. Ручные санкции Google

Эти санкции сотрудники Google накладывают вручную. Они проверяют сайты и отбирают «нарушителей».

Сайт может попасть под действие ручных санкций, если:

- ресурс был взломан;

- на него и с него ведут искусственные ссылки;

- он содержит бесполезный и неинформативный контент;

- на сайте установлена скрытая переадресация;

- сайт содержит скрытый текст.

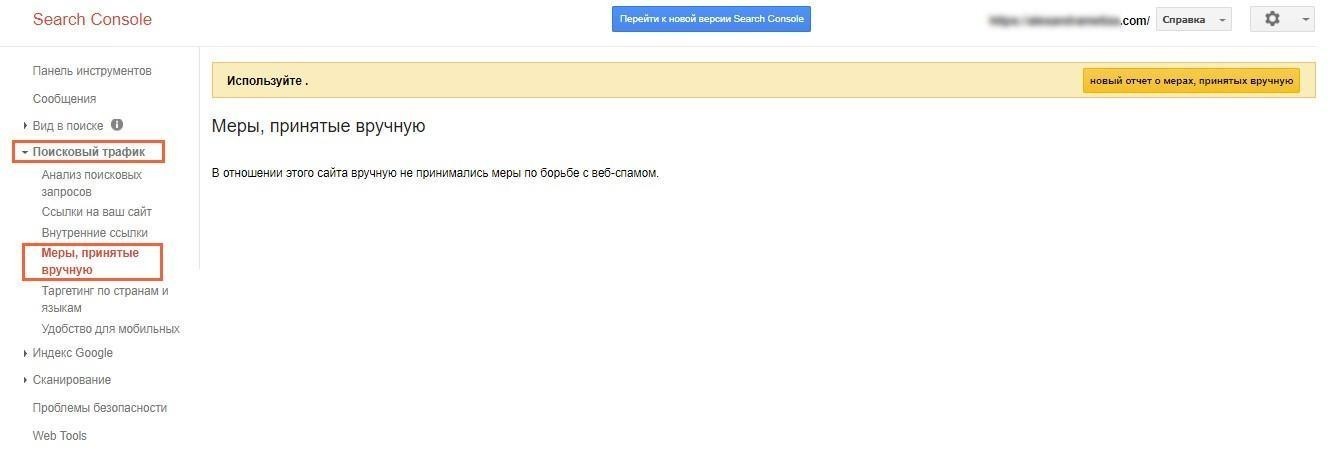

Как узнать, что сайт под фильтром Google? Уведомление о наложении санкций появляется в Google Webmaster в разделе «Меры, принятые вручную».

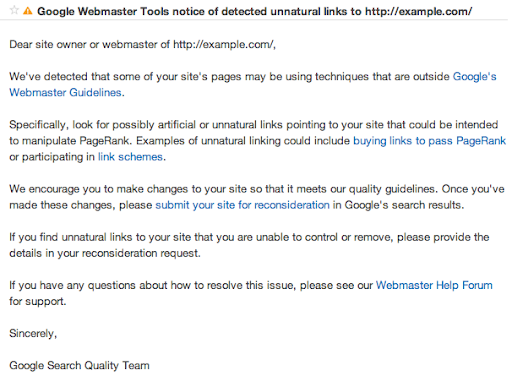

Если санкции ручные, в Google Webmaster появится следующее оповещение:

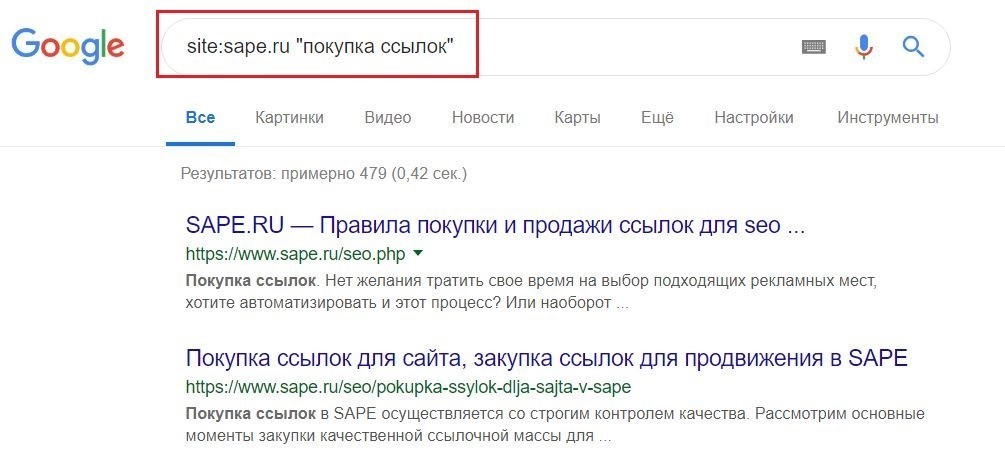

2. Автоматические санкции

Они «выписываются» определёнными алгоритмами Google. В отличие от ручных, оповещение об автоматических санкциях не появляется в Google Webmaster, и единственный сигнал — резкое снижение трафика и позиций ресурса в выдаче. Чтобы проверить, попал сайт под фильтры Google или нет, можно воспользоваться поисковыми операторами. Для этого в строку поиска введите «site:», домен вашего сайта и в кавычках укажите ключевое слово, по которому продвигаете ресурс в поиске.

Если в результатах выдачи не будет вашего сайта, скорее всего, он находится под штрафными санкциями Google.

Далее разберём наиболее влиятельные алгоритмы Google и рассмотрим причины, по которым ресурсы могут попасть под фильтры поисковой системы.

Алгоритмы поисковых систем

«Колибри» (Hummingbird)

Это основной алгоритм ранжирования Google. «Колибри» был создан, чтобы лучше понимать запросы пользователей и выдавать по ним наиболее релевантные сайты. Цель — сделать «разговорный» поиск. Например, если человек вводит запрос «фильм, в котором Ди Каприо борется с медведем», поисковая система выдаст страницу с фильмом «Выживший».

Часть алгоритма «Колибри» — самообучающаяся система искусственного интеллекта RankBrain, на основании которой и происходит формирование выдачи. RankBrain анализирует общий смысл контента, а не отдельные слова, благодаря чему результаты поиска ещё более точные.

Юлия Телижняк, контент-маркетолог Netpeak Software

Чтобы добиться расположения «Колибри», необходимо улучшать CTR и поведенческие факторы, наполнять сайт полезным контентом, который будет удовлетворять запросы пользователей и отвечать их интересам (точные вхождения запросов уже не так значимы при ранжировании, важны словоформы и наличие слов той же тематической группы — именно на их основе Google формирует результаты поиска).

Основной поисковый алгоритм «Колибри» включает следующие алгоритмы:

«Панда» (Google Panda)

- Этот алгоритм пессимизирует в выдаче ресурсы с низкокачественным контентом. Фильтр накладывается на сайт в следующих случаях:

- переспам ключевыми словами;

- дублирование контента на разных страницах ресурса;

- неуникальный контент;

- переизбыток рекламного контента;

- плохие поведенческие факторы ресурса (время на сайте, глубина просмотра и пр.).

«Пингвин» (Google Penguin)

Этот алгоритм призван бороться с неестественными обратными ссылками. Фильтр «Пингвин» накладывается на сайт, если на нём обнаружены:

- много некачественных покупных ссылок;

- обратные ссылки со спамных сайтов;

- ссылки, которые ведут на нерелевантные страницы;

- неестественные анкоры (только с прямым вхождением).

Mobile-friendly

Этот алгоритм пессимизирует сайты, которые не адаптированы под мобильные устройства. Он учитывает такие факторы, как скорость загрузки ресурса, удобство навигации (текст не написан мелким шрифтом, ссылки находятся на достаточном расстоянии друг от друга и пр.). Благодаря этому пользователям легче находить релевантные и качественные ресурсы.

«Фред» (Fred)

В SEO-среде считается, что это по большей части неофициальный апдейт Google.

За что «наказывает» «Фред»:

- за злоупотребление рекламными окнами и баннерной рекламой;

- нерелевантный контент;

- переоптимизированный контент, т. е. переспамленный ключевыми словами и не несущий пользы для читателя.

За что сайт может попасть под санкции поисковых систем

1. Некачественные ссылки

Наличие обратных ссылок является одним из главных факторов ранжирования и играет значимую роль в продвижении сайта. Однако в погоне за высокими позициями в выдаче многие владельцы ресурсов размещают некачественные ссылки. В результате сайт рискует попасть под фильтры Google.

Лучший способ избежать наказания от Google — постепенное наращивание естественной ссылочной массы. Для этого создавайте уникальный и полезный контент, на который будут ссылаться другие ресурсы. Ещё один метод — крауд-маркетинг — уместное упоминание и размещение ссылок на сайт на различных форумах, в соцсетях, постобзорах от лидеров мнений, в рассылках и пр.

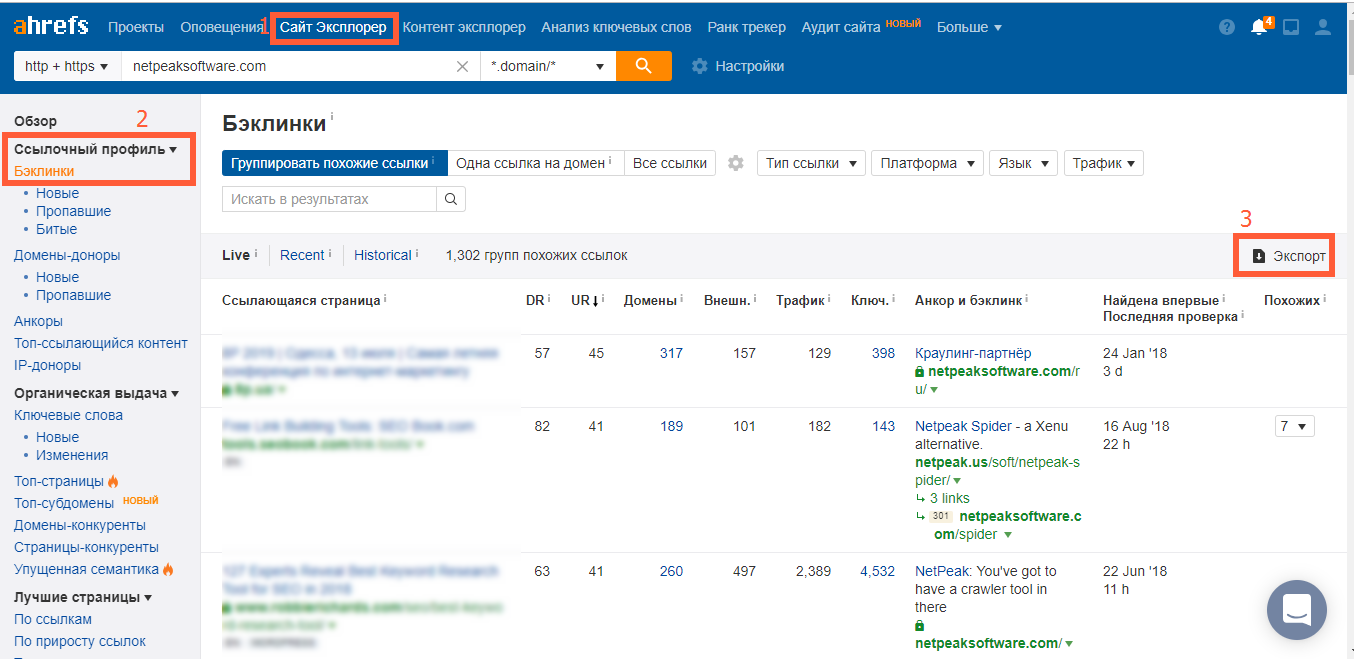

Чтобы проверить количество и качество обратных ссылок, воспользуйтесь такими сервисами, как Serpstat, Ahrefs, SEMrush, SE Ranking.

Например, в сервисе Ahrefs для этого достаточно перейти в раздел «Сайт Эксплорер», нажать на пункт «Бэклинки» и ознакомиться с ресурсами, которые ссылаются на ваш сайт.

Если обнаружили спамные ссылки, которые ведут с низкокачественных сайтов, удалите их. В этом поможет инструмент отклонения ссылок Disavow Links Tool. Просто выберите домен вашего сайта, нажмите на кнопку «Отклонение ссылок» и добавьте файл, который содержит плохие ссылки. Подробнее об отклонении обратных ссылок можете прочитать в справке Google.

2. Дублирование контента

Если на сайте содержится много разных страниц с идентичным содержимым, он неминуемо попадёт под фильтр Google «Панда». Это негативно скажется на индексации сайта (страницы будут дольше попадать в индекс) и, как следствие, на ранжировании. Именно поэтому одна из главных задач внутренней оптимизации — устранение дублей.

Чтобы их обнаружить, воспользуйтесь десктопными программами Netpeak Spider, Screaming Frog Seo Spider и Xenu.

3. Битые ссылки

Битые ссылки — это ссылки, которые ведут на несуществующие страницы. Из-за них поисковики хуже сканируют сайт и снижают его позиции в выдаче, а пользователи уходят, что ухудшает поведенческие факторы. Поэтому, чтобы не попасть под фильтры Google, важно удалить все битые ссылки.

Чтобы их найти, вы можете воспользоваться онлайн-сервисом Google Search Console, специальными плагинами Check My Links для Google Chrome и Broken Link Checker для WordPress или же вышеупомянутыми десктопными программами.

4. Переизбыток анкоров

Алгоритм Google Penguin строго наказывает сайты, которые занимаются манипуляцией позициями в поисковой выдаче за счёт дублирующихся анкоров. Он понимает, что вы искусственно наращиваете ссылочную массу и пытаетесь манипулировать алгоритмами ранжирования. Как результат — сайт рискует попасть под фильтры поисковой системы Google.

Чтобы избежать наказаний от «Пингвина»:

- Используйте анкоры ссылок, соответствующие тематике текста.

- Используйте уникальные и разнообразные анкоры. Если на каждой странице прописывать анкор «Купить ноутбук», поисковик определит это как переспам.

- Используйте 70–80 % разбавленных анкоров (когда помимо ключевых запросов есть и другие слова) и 20–25 % неразбавленных (с точным вхождением запроса).

- Правильно оформляйте гиперссылки с анкором. Гиперссылка должна подчёркиваться, выделяться синим цветом и выглядеть естественно по отношению к тексту.

Посмотреть анкоры сайта можно с помощью онлайн-сервиса xseo.in, сервисов Majesticseo и Ahrefs. Если при проверке вы обнаружили много спамных, нерелевантных и одинаковых анкоров, исправьте их в соответствии с вышеперечисленными рекомендациями. Учтите, что такая работа выполняется вручную. Если не хотите потратить потом слишком много времени на исправление, постарайтесь на этапе создания контента уделить особое внимание текстам анкоров.

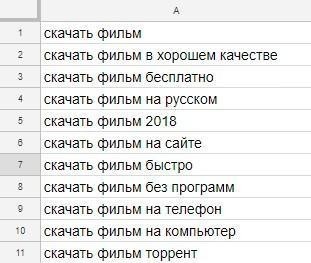

5. Переспам ключевыми словами

Чтобы минимизировать риск наложения штрафных санкций Google, придерживайтесь следующих рекомендаций по работе с ключевыми словами:

- используйте меньше прямых вхождений и больше LSI-фраз. При написании LSI-текстов используются синонимы и похожие фразы ключевого запроса, что повышает их релевантность для читателей;

- выбирайте фразы, которые относятся к тематике страницы, и избавляйтесь от всех «мусорных» слов;

- используйте определённое количество ключевых слов на странице. Оптимальным показателем плотности считается 1,5–3 % от всего текста. Считается, что самые эффективные фразы состоят из двух-трёх слов.

6. Неуникальный контент

Google с каждым годом становится умнее и уже умеет определять неуникальный контент (спасибо алгоритму «Панда»), так как это помогает:

- очистить выдачу от бесполезных сайтов и страниц;

- создать добросовестную конкуренцию.

Важно отметить, что помимо уникальности содержания большую роль играют качество и способность отвечать требованиям и интересам аудитории.

Качественный контент позволяет повысить доверие к сайту как со стороны пользователей, так и со стороны поисковых систем. Проверить текст на уникальность можно с помощью различных сервисов, например eTXT, Advego, Text.ru. Оптимальный показатель уникальности, за который Google не станет наказывать, — это 85 % и выше.

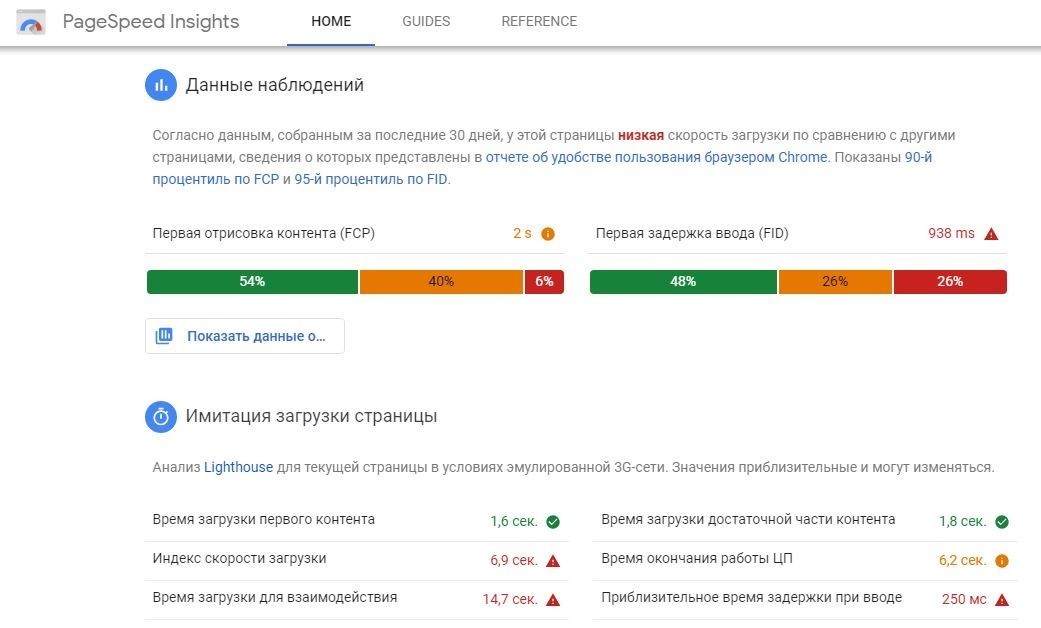

7. Медленный ответ сервера и загрузка контента

Идеальный показатель скорости загрузки сайта — 200 мс, оптимальный — до 500 мс. Сайты, скорость загрузки которых превышает 500 мс, зачастую плохо воспринимаются пользователями: они не хотят ждать загрузки страниц и уходят. Но Google стал пессимизировать такие ресурсы не по этой причине. Дело в том, что пользователи реже используют сам поисковик, если в выдаче находятся медленные сайты.

Поэтому важно оптимизировать скорость загрузки страниц ресурса. Чтобы проверить, как быстро они загружаются, воспользуйтесь бесплатным инструментом от Google PageSpeed Insights, где достаточно добавить URL и запустить анализ.

Вот несколько базовых советов, которые помогут ускорить загрузку сайта:

- Избавьтесь от ошибок на сайте.

- Уменьшите размер исходного кода страниц, чтобы «облегчить» их.

- Настройте автоматическое кеширование.

- Поместите сайт на хостинг с более производительным сервером.

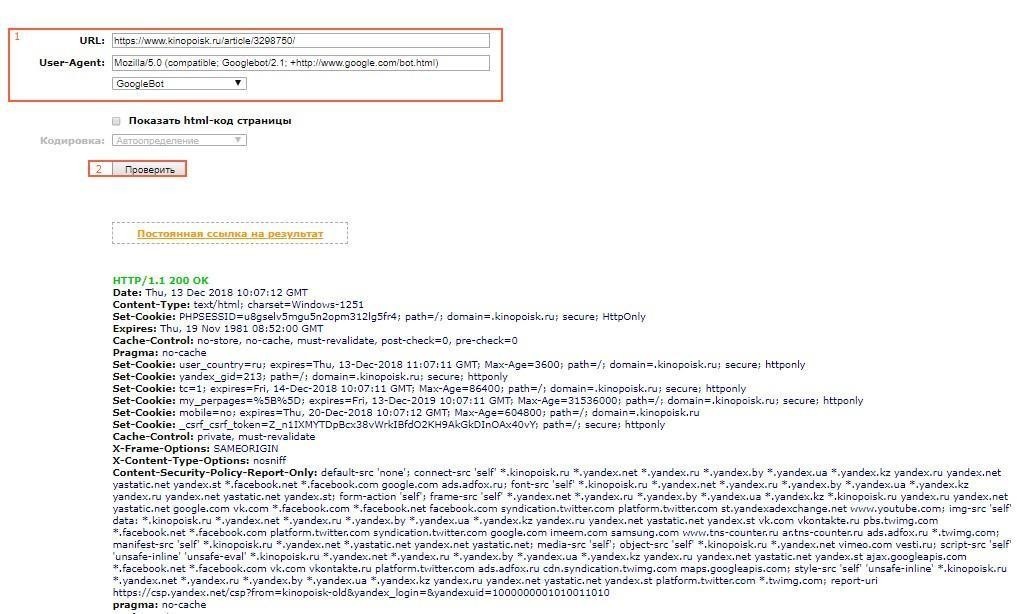

8. Скрытый текст на сайте

Скрытый текст нередко используется для манипуляции позициями сайта в выдаче. Для этого на страницах размещают невидимый контент, насыщенный ключевыми словами и фразами. Таким образом, посетители текст не видят, но роботы его индексируют. Это является чёрной методикой, за которую Google накладывает ручные санкции. Чтобы проверить, нет ли на страницах скрытого текста, нажмите сочетание клавиш Ctrl+A либо откройте исходный код и посмотрите в нём.

Ещё один способ проверить наличие скрытого текста в виде ссылок — указать URL страницы в сервисе Bertal и выбрать формат просмотра GoogleBot.

Поисковики не наказывают сайты за скрытый текст, если:

- на сайте содержится JavaScript, изображения, Flash-файлы и другой похожий контент, без описания которого поисковой системе будет сложно его проиндексировать;

- необходимо добавить скрытый блок меню, подсказки или анонсы для удобства посетителей и повышения юзабилити сайта.

9. Перебор с рекламными объявлениями

В рекламных объявлениях нет ничего плохого, когда они не агрессивны и используются умеренно. Если же при переходе на сайт сразу появляются всплывающие окна, предложения оформить подписку, перезвонить, то показатель отказов, скорее всего, увеличится, так как навязчивая реклама отвлекает внимание и мешает пользователю ознакомиться с ресурсом.

Правила размещения рекламы на сайте довольно просты, но всё же многие ими пренебрегают. Итак, на что нужно обратить внимание:

- Избегайте навязчивости. Реклама не должна раздражать пользователей и перекрывать контент.

- Делайте её нативной. Подбирайте рекламу, которая соответствует тематике сайта или страницы.

- Старайтесь привлекать внимание правильно. Реклама должна быть красочной и красивой, но в то же время не должна резко бросаться в глаза.

- Отделяйте рекламу от основного контента. Правилами Google запрещено оформлять рекламу в точности как контент страницы.

- Не размещайте рекламу под заголовками страницы, чтобы не вводить пользователей в заблуждение.

Чтобы узнать все тонкости работы с рекламой, ознакомьтесь с советами Google в разделе справки «Обеспечение надлежащего размещения рекламы».

10. Плохая репутация домена

Если в прошлом домен вашего сайта имел плохую репутацию (спам, покупка некачественных ссылок, чёрное SEO), то заново добиться доверия поисковых систем достаточно сложно. Поэтому перед покупкой домена советуем тщательно проверять его качество. Сделать это можно с помощью сервисов Ahrefs, Majestic, Alexa, Majestic, Netpeak Checker и др.

Как выйти из-под фильтров Google

1. Как снять ручные санкции

Как правило, алгоритм снятия ручных санкций Google одинаков независимо от типа нарушения. Итак, что нужно сделать:

- Устраните все ошибки на сайте. При этом не забудьте всё перепроверить и убедиться, что всё исправлено, прежде чем связываться с поддержкой Google.

- Напишите в поддержку Google с просьбой проверить сайт повторно. Опишите в письме методы, которые вы применяли для борьбы с проблемами, и обязуйтесь не повторять ошибок. Важно подробно описать все детали, чтобы сотрудники Google правильно всё поняли и сняли санкции с сайта.

Если получили отказ, не опускайте руки. Проделайте ещё одну, более тщательную, «чистку» сайта, а затем снова уведомите об этом сотрудников Google.

Как показывает практика, сайты, которые стараются выйти из-под фильтров Google, рано или поздно добиваются своего.

Подробнее о методах снятия санкций можно также прочитать в справке Google.

2. Как снять автоматические санкции

Методы снятия автоматических санкций Google примерно такие же, как и ручных. Минус в том, что писать некому, необходимо ждать, пока Google сам отменит санкции (это может занять от недели до нескольких месяцев).

Если все попытки выйти из-под фильтра оказались тщетны, придётся создавать новый ресурс и заниматься его продвижениям с нуля, избегая прежних ошибок. Однако это необходимо делать только после того, как все остальные методы «спасения» ресурса от санкций были испробованы, но не сработали.

И последнее: ни в коем случае не настраивайте редирект с сайта, на который были наложены санкции, иначе новый ресурс, скорее всего, также окажется под фильтрами Google.

Предотвратить попадание сайта под фильтры Google намного проще, чем вывести ресурс из-под них: требуется меньше времени, сил и терпения. Поэтому рекомендую минимум раз в полгода проверять, какова вероятность попадания сайта под фильтры поисковых систем. Если она увеличилась, примите необходимые меры по устранению ошибок. Не стоит дожидаться часа X, когда вы перестанете получать трафик.

Вам была полезна эта статья?

0

0

Похожие статьи