26 августа 2020

Апдейты поисковых алгоритмов Google и Яндекса — мануал для вебмастеров

13019

Поисковые системы внедряют апдейты, чтобы сделать выдачу максимально релевантной для пользователя. Но каждый вебмастер встречает обновление поискового алгоритма с тревогой: некоторые сайты в результате апдейтов понижаются в выдаче, а некоторые, наоборот — растут и занимают топовые позиции. То есть апдейты априори не работают на понижение.

Давайте разберемся в особенностях самых популярных апдейтов алгоритмов Яндекса и Google, а также в отличиях апдейтов алгоритмов от санкций поисковых систем.

Поисковые алгоритмы vs. Ручные санкции

Алгоритмы созданы для улучшения качества поисковой выдачи, а вот санкциями наказывают тех, кто использует нечестные методы продвижения. Понижающие алгоритмы — это не приговор сайту, а только намек, что сайт недостаточно оптимизирован. Если после очередного обновления у вашего сайта просели позиции и трафик — вы сможете их восстановить: исправить ошибки внутренней и внешней оптимизации, удалить дубли страниц и контента. А вот если сайт попадет под санкции при злоупотреблениях черными методами продвижения, возможно, придется и вовсе забыть про этот сайт и создавать новый. Хотя все индивидуально — иногда можно договориться.

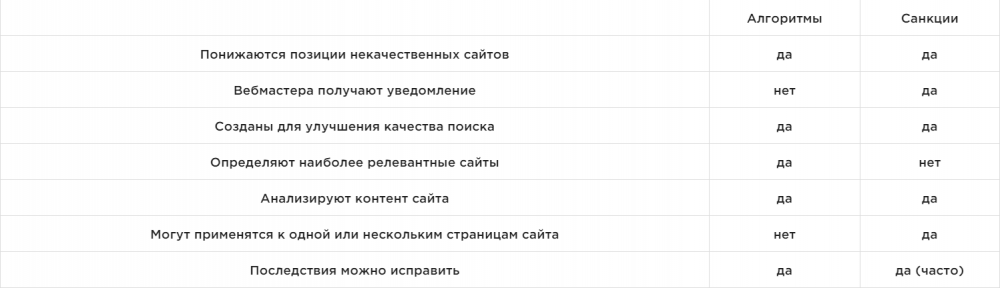

Отличия автоматических алгоритмов от ручных санкций:

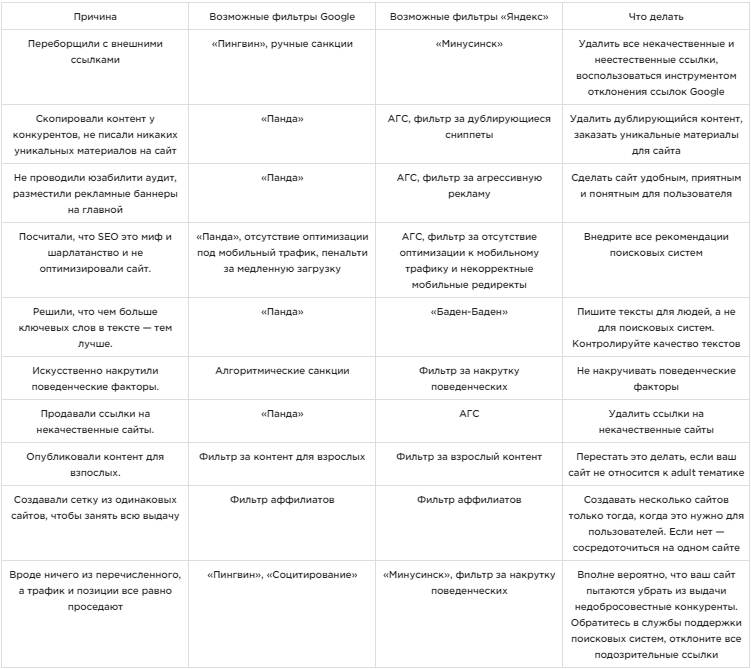

Почему сайт теряет позиции и трафик из-за санкций или алгоритмов и что с этим делать

Как не попасть под ручные санкции

Самый действенный и очевидный ответ — не нарушать рекомендации поисковых систем. Но давайте признаемся: все оптимизаторы вынуждены действовать с помощью «серых» методов продвижения для успеха своего проекта.

Так что постарайтесь просто соблюдать правила предосторожности:

- пишите тексты для людей, не злоупотребляя количеством ключевых слов;

- то же правило и для метатегов — не нужно просто перечислять ключевые слова в title и description, сделайте их привлекательными и информативными, чтобы пользователю хотелось кликнуть именно по вашей ссылке;

- тексты, и теги должны быть уникальными для всего сайта: дублирующийся контент — плохой сигнал;

- постарайтесь получать внешние ссылки благодаря качественному контенту, но если уж покупаете их — следите за показателями сайтов-доноров, не размещайте ссылки на «сайтах-помойках»;

- юзабилити — это важно. Ваш сайт должен быть удобным для пользователя, все формы должны работать корректно, а пользователь не должен потеряться в недрах структуры;

- внедряйте рекомендации относительно дизайна сайта — он не должен быть порталом в 90-е;

- оптимизация мобильной версии сайта тоже очень важна. Её отсутствие или реализация с кучей ошибок — прямой сигнал для поисковых систем о том, что у вас некачественный ресурс;

- постоянно проверяйте сайт на дубли страниц и 404 ошибки.

Апдейты поисковых систем

Апдейты основного ядра Гугл и Яндекс тоже приносят немало хлопот вебмастерам и оптимизаторам.

Апдейты поисковых алгоритмов Google

1. Panda («Панда»)

Google Panda родом еще с 2011 года. Но после 2016 «Панда» превратилась в сигнал ранжирования. Именно «Панда» следит за качеством контента в выдаче. Алгоритм создан, чтобы исключить из индекса страницы, на которых:

- Много неуникального контента.

- Переспам ключевых слов в текстах и тегах.

- Дублируется контент внутри сайта.

- Большое количество рекламных материалов и баннеров.

- Низкие показатели поведенческих факторов (высокий показатель отказов, низкое время пребывания на странице и так далее).

Как не призвать «Панду» в гости? Очень просто: качественные тексты, разумное количество ключевых слов и минимум рекламных баннеров (а лучше вообще без них).

2. Penguin («Пингвин»)

«Пингвин» появился в 2012 году для борьбы с нечестными вебмастерами, которые искусственно повышали позиции сайта за счет огромного количества внешних ссылок. Алгоритм снижал позиции страниц сайта, на которые вело огромное количество искусственных и некачественных ссылок.

Вместе с «Пандой» в 2016 году этот фильтр стал частью основного алгоритма Google. Вместе с этим он перестал наказывать напрямую, а стал просто обесценивать и игнорировать некачественные ссылки. Некоторые страницы, которые держали позиции только благодаря этому, просели, но не массово. Если вы и после этого не остановились, тогда сотрудники Гугл вручную примут меры и уведомят вас про это с помощью Google Search Console.

Как не попасть под Penguin? Очень просто: не переборщите со ссылками и используйте только качественные доноры.

3. Pirate («Пират»)

Алгоритм пират появился в 2012, он призван для борьбы с украденным контентом. «Пират» понижает сайты, на которые жалуются правообладатели авторского контента. В первую очередь это ресурсы с пиратской музыкой, фильмами, книгами.

Есть мнение, что если ваш ресурс попал под данный алгоритм, проще всего создать новый сайт, так как на восстановление уйдет много времени и ресурсов.

Как не попасть под Pirate? Не используйте авторский контент, если у вас нет на него прав.

4. Hummingbird («Колибри»)

Google выпустил «Колибри» в 2013 году: поисковая система начала понимать содержимое страницы, а точное вхождение ключевых слов стало неактуальным. Сайты, которые не использовали синонимы, а просто «нашпиговали» тексты поисковыми запросами, потеряли часть позиций и трафика, а пользователи получили более осмысленную и релевантную выдачу.

Как избежать негативного влияния «Колибри»? Писать тексты для людей, уделяя больше внимания смыслу, а не количеству ключевых слов.

5. Pigeon («Голубь»)

«Голубь» появился в 2014 году. Ажиотаж вокруг апдейта был вызван тем, что с этого момента Google понимал локализацию запросов. Он учитывал расположение пользователя и показывал ему места и компании, которые находятся ближе к нему.

6. Mobile friendly

Обновление mobile friendly в 2015 году никак не задело десктопную версию, но именно с него понемногу начинается эра доминирования мобильной выдачи. Теперь хорошо оптимизированные под мобильные сайты получают более высокие позиции.

7. RankBrain

Апдейт RankBrain вышел через полгода после mobile friendly, тоже в 2015 году. Это обновление уникально тем, что поисковая машина стала понимать не только тематику страницы, но и ее релевантность поисковому запросу пользователя. Также RankBrain учитывает «пользовательский опыт» — показатели отказов и поведенческие факторы при формировании выдачи.

8. Possum («Опоссум»)

Действует Опоссум с сентября 2016 года. Он создан, чтобы повышать позиции сайтов, релевантных запросу и расположению пользователя. Благодаря этому обновлению в выдаче стало меньше компаний с одинаковыми адресами и телефонами (выдача стала более разнообразной). Также в выдаче появились компании, расположенные в пригороде, по запросам с названием города (такого раньше не было).

9. Fred («Фред»)

Фред пришел в выдачу в 2017 году, чтобы убрать сайты, которые зарабатывали на рекламе. Именно те «помойки» с изобилием рекламных баннеров, большим количеством исходящих ссылок и переспамленными текстами. Именно благодаря ему почти умерли «черные» методы SEO-продвижения, так как Fred просто не позволяет таким сайтам подняться в топ.

Как избежать проседания из-за «Фреда»? Пишите тексты для пользователя и знайте меру в использовании ключевых слов.

10. Google Medic Update («Медицинский апдейт»)

Медицинский апдейт Гугл случился в августе 2018 и сильно поменял выдачу. Многие сайты оказались далеко за топ-100, появилось понятие «YMYL-сайт» (Your Money or Your Life), а специалисты стали обращать внимание на факторы контента E-A-T (экспертность, авторитетность, доверие). Теперь важно, чтобы материалы публиковали эксперты и при этом использовали надежные источники. Несмотря на название, «Медицинский апдейт» (также известен как «Широкомасштабное обновление алгоритма») повлиял на сайты в отраслях, не относящихся к здоровью или сайтам YMYL.

Апдейты поисковых алгоритмов Яндекса

1. Версия 7 и 8

Первые апдейты Яндекса назывались просто «Версия 7» и «Версия 8». Они вышли в 2007 году, с разницей меньше чем в полгода. Были внедрены новые формулы ранжирования. Авторитетные сайты получили преимущество в ранжировании, появился фильтр для борьбы с накруткой ссылочных факторов. В целом, поиск начал приспосабливаться к пользователю.

2. «Магадан»

Магадан запустили в мае-июле 2008, и он стал первым алгоритмом, которому дали имя. С этим апдейтом у Яндекса вдвое выросло количество факторов ранжирования, появилась классификация коммерческих и гео запросов, появились факторы проверки уникальности контента.

3. «Арзамас»/«Анадырь»

Этот апдейт (запущен в апреле-сентябре 2009) подарил пользователям Яндекса геозависимую выдачу, поисковая система начала использовать региональную формулу для геозависимых запросов, а значит пользователи стали получать релевантный для своих регионов контент.

4. «Снежинск»

Снежинск вышел под конец 2009 года и стал первым алгоритмом на базе машинного обучения (платформа MatrixNet). Поисковые алгоритмы дополнили новыми факторами ранжирования, а также доработали формулы для 19 регионов РФ.

5. «Рейкьявик»

Этот алгоритм вышел в 2011 году и благодаря ему выдача начала понимать языковые предпочтения пользователя. Это первый шаг в сторону персонализированной выдачи для Яндекса. Именно с этого момента поисковая система предлагает исправление опечаток в запросе.

6. «Калининград»

Обновление «Калининград» (появилось 12 декабря 2012 года) принесло пользователям первые поисковые подсказки и первые осложнения для SEO-специалистов. Поисковые системы начали комплексно оценивать оптимизацию сайта, обращая внимание на качество контента, ссылочный профиль, юзабилити, социальные сигналы.

7. «Минусинск»

В 2015 году вышел «Минусинск» — первый понижающий алгоритм Яндекса. Именно из-за него начали снижаться позиции сайтов с избытком искусственных ссылок в ссылочном профиле. В работах по продвижению Яндекс рекомендовал уделить внимание качеству контента и дизайна сайта.

8. Многорукие бандиты Яндекса

Многорукие бандиты Яндекса также появились в 2015 году. Они разбавили выдачу молодыми ресурсами, чтобы оценивать поведенческие факторы пользователей.

9. «Баден-Баден»

«Баден-Баден» выкатили в 2017 году, апдейт был направлен на то, чтобы исключить из выдачи ресурсы с переоптимизированными текстами. В основной алгоритм встроили ряд факторов, которые определяли контент с переспамом ключевых слов и понижали такие ресурсы.

10. «Вега»

Свежее обновление «Вега» (2019 год) касалось ускорения поиска и повышения скорости индексации документов. Также появилось понятие экспертности в оценках асессоров для повышения качества выдачи в тех тематиках, где пользователю особенно важен экспертный контент. К тому же появились настройки гиперлокальности поиска, который начал учитывать не только город пользователя, но и район.

Запомнить

Если у вашего сайта резко начали падать позиции\трафик — не паникуйте. В первую очередь необходимо проверить, попал ли ваш ресурс под санкции, или же поисковая сеть изменила алгоритмы. О ручных санкциях к сайту и его отдельным страницам вас уведомят в Google Search Console или панели вебмастеров Яндекса.

Если произошло общее обновление алгоритма, нужно просто подождать: возможно, скоро ситуация в выдаче стабилизируется и ваш сайт вернется на место. В любом случае следует соблюдать простые правила, которые помогут не попасть под санкции и не пострадать от апдейтов:

- пишите контент для пользователей, не злоупотребляя ключевыми запросами;

- проставляйте ссылки преимущественно естественным путем, выбирайте качественных и трастовых доноров;

- сайт необходимо постоянно проверять на наличие технических ошибок и вовремя их устранять;

- сайт должен быть удобным и понятным для пользователя;

- контент должен быть уникальным, без дублей как на внутренних страницах, так и на внешних ресурсах.

Вам была полезна эта статья?

0

0

Похожие статьи