Интересное исследование от пользователя Reddit, которое он провел, опираясь на данные собственных, а также клиентских проектов. Как борьба Google со спам-контентом отразилась на ранжировании и трафике в 2022 году? Материал для размышления всем SEO-шникам и владельцам сайтов.

Из-за характера моей работы — владения довольно большим количеством веб-сайтов, консультирования и создания веб-сайтов для клиентов, я хотел написать статью с некоторыми из моих случайных находок о последнем обновлении Google Spam.

В предисловии хочу сказать, что я работаю как в белых, так и в серых нишах. Я много занимаюсь искусственным интеллектом/программным SEO и генерацией текста/изображений. Если большая часть трафика исходит от белого контента, я классифицирую этот сайт как белый, и наоборот.

Вводные данные

- Всего 327 сайтов, из них 259 - в серой нише, 68 - в белой.

- 49 blackhat сайтов подверглись негативному воздействию (19%).

- 12 “белых” сайтов подверглись негативному воздействию (17%).

- Под негативным воздействием имеется в виду большое влияние (-50% трафика).

Я довольно много работаю с Python и Google Search Console API и через это получил много данных.

Многие сайты выиграли от обновления, но трудно судить, что на самом деле способствовало тому или иному изменению. Это не статистически значимое исследование или что-то, что можно точно измерить, поскольку сайты находятся в разных нишах, были созданы разными авторами, имеют разные методологии исследования ключевых слов, внутреннее SEO и т. д.

Я руководствуюсь своей интуицией, сравнивая сайты, принесшие профит, с пострадавшими больше всего.

И еще кое-что. После обновления я создал целую кучу программных сайтов для проверки различных гипотез относительно спам-сайтов.

Субъективные выводы

В чем я уверен на 100%

1. Тот факт, что веб-сайт подвергся атаке, не означает, что это повлияет на веб-сайты, принадлежащие той же консоли поиска Google.

2. Если вы запустите сайт, разместите на нем 10 000 сгенерированных ИИ статей в первый же день и принудительно проиндексируете с помощью GSC/Instant Indexing API, произойдет это:

3. Если вы сделаете то же самое и позволите Google медленно индексировать сайт, вы не будете наказаны (по крайней мере, такова текущая ситуация на каждом сайте, который я пробовал).

В чем я уверен на 90%

1. Google не обнаруживает ИИ-контент сам по себе, но наказывает за слабый контент, скорее всего, с помощью простых алгоритмов NLP (Natural Language Programming) для обнаружения чрезмерного наполнения ключевыми словами, повторений и т. д.

2. Google не наказывает сайты с очень сильными обратными ссылками, устаревшими доменами и органическим трафиком, даже если контент слабый. При условии, что количество страниц хорошо коррелирует с вашим трафиком (см. ниже).

3. Google ориентируется на веб-сайты с плохим соотношением трафика и количества страниц. 1 миллион проиндексированных страниц и всего 500 тысяч посещений в месяц? Наверное, попадут под алгоритм.

4. На белых сайтах удаления слабого контента и добавления солидного, плюс трастовые обратные ссылки, похоже, достаточно для того, чтобы снять штрафные санкции.

5. Сайты в очень ценных / YMYL-нишах были поражены больше. Технологии, домашние животные, VРN и т. д. Похоже, что Google отдал эти позиции крупным и богатым «сетевым» сайтам.

6. Сайты с низким уровнем ИИ в нишах с нулевой конкуренцией преуспевают.

7. Google обновил свой алгоритм, чтобы он действовал и на неанглоязычных сайтах. Больше никаких простых рейтингов с супердерьмовым содержанием на французском, немецком, итальянском и т. д.

О чем я только догадываюсь

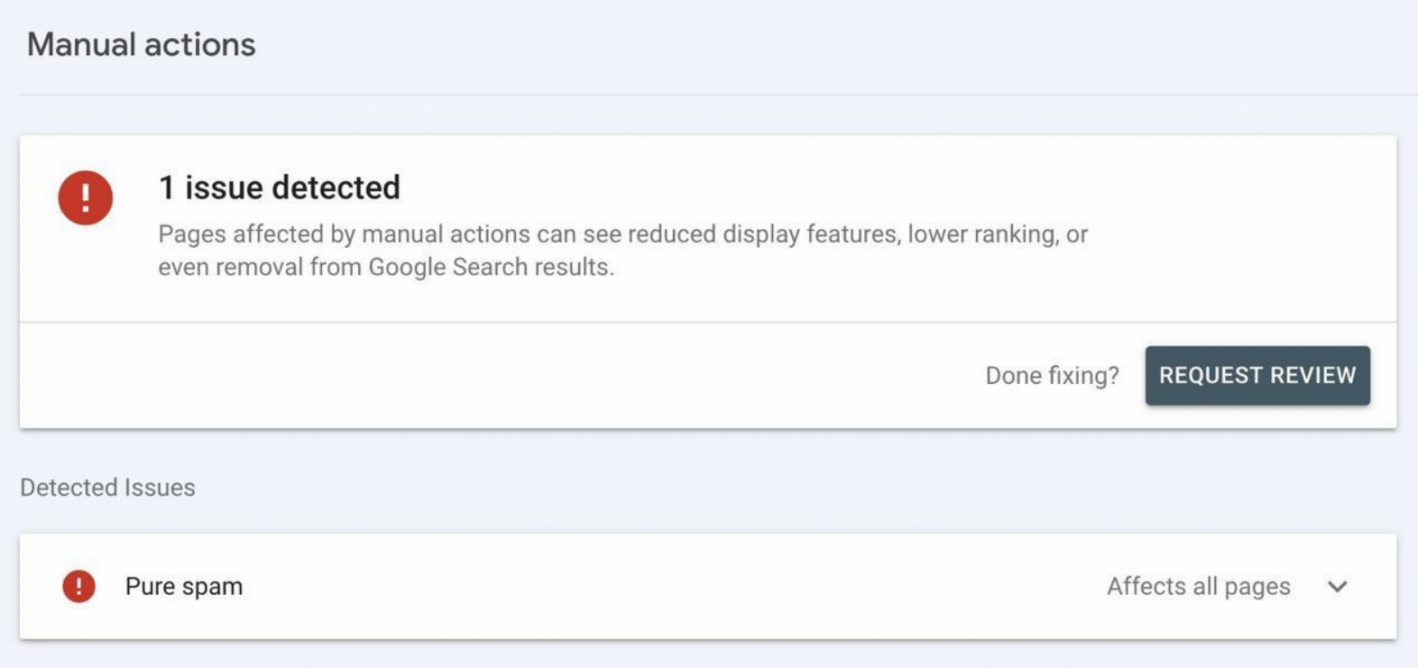

1. Оштрафованные домены каким-то образом помечаются как «плохие», хотя в Google Search Console нет ручных штрафов. Много плохих статей и несколько хороших статей на сайте повлияют на эффективность хороших статей.

2. Сайты со слабым E-A-T, уродливыми темами и стоковыми изображениями больше пострадали. Возможно, из-за ручных оценок?

Что меня удивило

1. Похоже, что домены с точным соответствием вдруг стали играть важную роль в ранжировании. Может быть, это случай чрезмерной оптимизации алгоритма из-за слишком большой зависимости от нейронных сетей?

2. Некоторые откровенно спамные сайты все еще работают. Сайт midogguide(dot)com, основанный на копипасте и Google Translate, по-прежнему получает около 500 тысяч посещений в месяц, имея при этом 1,35 миллиона проиндексированных страниц. Что за черт?

В конце концов, за последние 20 лет ничего не изменилось, так что если вы хотите много работать и добиваться успеха:

- Создавайте отличный контент, который представляет реальную ценность для пользователя.

- Размещайте его в социальных сетях.

- Пользователи делятся вашим контентом, и вы получаете органические обратные ссылки.

- Повторите пункты 1-3.

- Включите рекламу.

- Profit!

Я никогда не видел, чтобы крутой сайт подвергался наказанию.